Dawid Zawadzki

Użytkownik-

Postów

6 -

Dołączył

-

Ostatnia wizyta

Reputacja

1 Nowy-

Podstrona zniknęła z indeksu Google

Dawid Zawadzki odpowiedział(a) na Dawid Zawadzki temat w White Hat

Update: Google jednak zdecydował, żeby zaindeksować obie wersje artykułu nawet przy takiej nie-przyjaznej strukturze linków. Ale wiem, że macie rację i piszę właśnie router PHP, żeby wszystkie linki były już takie jak powinny być zanim opublikuję na blogu te wszystkie teksty, które chciałbym na nim opublikować. Tak jak radzicie na starych adresach zrobię przekierowanie 301. Jeszcze raz dziękuję za podpowiedzi -

Podstrona zniknęła z indeksu Google

Dawid Zawadzki odpowiedział(a) na Dawid Zawadzki temat w White Hat

Faktycznie, muszę zrobić to lepiej... Dzięki za odpowiedź. Czy po tym jak wszystkie linki będą przyjazne dla wyszukiwarek powinienem zgłosić do Google usunięcie starych linków, czy po prostu czekać aż bot sam to ogarnie? -

Opis przypadku: Startuję z blogiem, żeby przyciągnąć trochę ruchu organicznego na stronę z produktem SaaS + nowych partnerów do programu partnerskiego. Strona jest w języku polskim i angielskim i również artykuły na blogu będą w dwóch wersjach językowych. Wczoraj googlebot dorzucił do indexu pierwszy artykuł w obu wersjach językowych, jednak wersja polska zniknęła po kilku godzinach. Teksty są autorskie, nie ma żadnej treści skopiowanej od kogoś innego i trochę mnie to martwi. Żeby dać pełny kontekst - blog jest autorski (nie jest to WordPress) a struktura linków jest trochę nietypowa: Wersja EN danego artykułu: https://strona/blog.php?id=1 Wersja PL tego artykułu: https://strona/blog.php?id=1&lang=2 Struktura strony również jest nietypowa, bo o ile wersja angielska ma standardową strukturę drzewa, to każda polska strona z perspektywy bota jest podstroną odpowiadającej jej strony angielskiej, a nie jest tak, że bot widzi osobną niezależną strukturę dla wersji angielskiej i jej kopię w wersji polskiej. Nie ma żadnych ograniczeń wynikających z robots.txt lub tagu meta "robots" (jest na all,follow). Polska wersja artykułu, która zniknęła z indexu nie ma duplikatu ani w ramach tej samej domeny, ani gdzie indziej w internecie. Może powinienem jeszcze chwilę dać Google, żeby się namyśliło, albo żeby dało mi informację zwrotną przez Google Search Console (tam dane strony mam sprzed 4 dni), ale jeśli mogę coś poprawić, chciałbym to zrobić jak najszybciej. Powinienem zgłosić ją do ponownego zaindeksowania przez Search Console, czy to nic nie da? Może źle zaprojektowałem strukturę linków lub strony?

-

Reaktywacja strony po 9 miesiącach

Dawid Zawadzki odpowiedział(a) na Dawid Zawadzki temat w White Hat

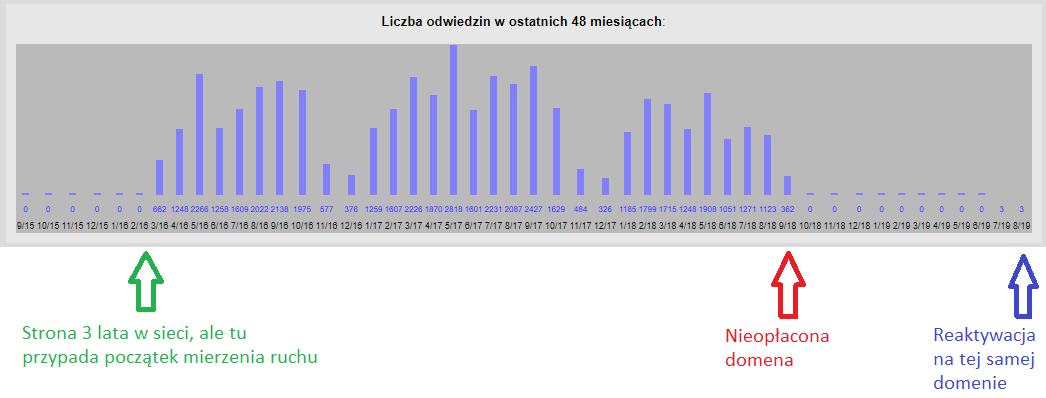

Sytuacja po 2 dniach: Googlebot zaczął się kręcić po stronie, ilość ponownie zaindeksowanych stron: 5, odwiedzin: 0 (póki co nic nie robię, żeby to przyspieszyć, tylko obserwuję). -

Reaktywacja strony po 9 miesiącach

Dawid Zawadzki odpowiedział(a) na Dawid Zawadzki temat w White Hat

Dzięki za podpowiedzi. Wygląda na to, że tekstów nikt nie zakosił. Ja jestem bardzo ciekaw jak będą wyglądały odwiedziny jak po prostu ją przywrócę do życia nie robiąc nic więcej i jaki efekt przyniesie odświeżenie treści + dodanie nowej. Zostawię temat na kilka tygodni i zobaczymy jak to będzie wyglądać ? -

Cześć Może ktoś z Was miał podobne doświadczenia, ale ponieważ przeprowadzam nieplanowany eksperyment, którego pewnie większość osób świadomie by nie zrealizowała, podzielę się informacjami jak rozwija się sytuacja. Opis przypadku: Strona o tematyce edukacyjnej założona w 2012 roku z około 110 zaindeksowanymi podstronami aktywna do końca 2018 roku. Statystyki odwiedzin na załączonym obrazku mierzone od marca 2016. Nieopłacona domena we wrześniu 2018 roku - strona wyleciała z obiegu. Reaktywacja dzisiaj (początek sierpnia 2019) + dodany sitemap do Google. Pytanie do Was - co mogę jeszcze zrobić, żeby przyspieszyć powrót do wcześniejszej kondycji strony? Jak czas pozwoli, będę pisał w tym wątku co dalej zrobiłem + jak zmienia się ilość odwiedzin. D.