Jak radzić sobie ze znikającymi wynikami naszych stron w Google?

-

Make-Cash.pl tworzą praktycy

Wypowiedzi użytkowników forum są oparte na realnym doświadczeniu w zarabianiu online i tematach pokrewnych. Posty są aktualizowane i weryfikowane przez moderatorów oraz użytkowników.

-

Ostatnio aktywne tematy

-

- 4 odpowiedzi

- 55 wyświetleń

-

Venga App - szybkie 10€ za proste warunki. 1 2

Przez AlbertKaczmarzyk, w Giełdy, portfele, kantory i bitomaty

- 25 odpowiedzi

- 870 wyświetleń

-

- 0 odpowiedzi

- 17 wyświetleń

-

- 1 odpowiedź

- 68 wyświetleń

-

Jaki według Ciebie jest najlepszy model AI do codziennej pracy?

Przez itmaster, w Sztuczna inteligencja (AI)

- 10 odpowiedzi

- 196 wyświetleń

-

-

Polecana zawartość

-

![⭐️ [OFICJALNY MENTORING] Unikalne poradniki, skuteczne zarabianie online! Dostęp LIFETIME!](//make-cash.pl/applications/core/interface/js/spacer.png)

⭐️ [OFICJALNY MENTORING] Unikalne poradniki, skuteczne zarabianie online! Dostęp LIFETIME!

mysc opublikował(a) temat w Poradniki i nisze,

Sprawdź nasz oficjalny mentoring zarabiania na Make-Cash.pl. Stale aktualizowane poradniki, skuteczne metody i wsparcie mentorów. Pomożemy Ci efektywnie zarabiać przez Internet - dołącz do nas!

DOSTĘP DO PORADNIKÓW OTRZYMASZ BEZPOŚREDNIO NA MAKE-CASH.PL

Jedno konto = wszystkie funkcjonalności getpaid20.pl i make-cash.pl-

-

- 177 odpowiedzi

Wybrany przez

mysc, -

-

Answer Engine Optimization (AEO) i Generative Engine Optimization (GEO) to nowe SEO

mysc opublikował(a) wpis na blogu w Blog Make-Cash,

Internet się zmienia na naszych oczach. Obecnie nie można już patrzeć na SEO w oderwaniu od AEO i GEO. Trzy te elementy są ze sobą powiązane i wspólnie decydują o sukcesie w widoczności online. Klasyczne SEO nadal pozostaje podstawą, ale jego rola się zmniejsza - staje się narzędziem wspierającym. Największą wartość w nadchodzących latach moim zdaniem będą miały treści tworzone pod kątem sztucznej inteligencji, odpowiadające na pytania i łatwe do wykorzystania w generatywnych podsumowaniach.-

-

- 1 odpowiedź

Wybrany przez

mysc, -

-

![[PORADNIK] Jak zacząć zarabiać na płatnych publikacjach artykułów sponsorowanych?](//make-cash.pl/applications/core/interface/js/spacer.png)

[Poradnik] Podstawy zarabiania na artykułach sponsorowanych

mysc opublikował(a) temat w Sprzedaż reklam,

Zarabianie na artykułach sponsorowanych to obecnie jedna z najbardziej popularnych możliwości zarabiania przez Internet. Latami była to niby oczywista, a jednak bardzo niedoceniana metoda monetyzacji stron internetowych.

Niby każdy wiedział, że może tak zarabiać.. a jednak właściciele blogów, portali tematycznych czy stron firmowych skupiali się przede wszystkim na afiliacji, google adsense, bannerach, itd.-

-

- 16 odpowiedzi

Wybrany przez

mysc, -

-

[Poradnik] Afiliacja biur podróży i sposób na tańsze wakacje

mysc opublikował(a) temat w Poradniki CPA,

Jak zarabiać na reklamowaniu wakacji i samemu pojechać na nie taniej?

Reklamowanie wakacji do prostych nisz afiliacyjnych niestety nie należy - natomiast w okresie wakacyjnym, zwłaszcza z wyjazdów last minute kupowanych pod wpływem chwili (czas ucieka = ostatnie wolne miejsca = trzeba się decydować szybko) - można zgarnąć dodatkowe przychody na JUŻ POSIADANYM zapleczu.

Kolejna możliwość to zakup własnych wakacji poprzez własny link afiliacyjny - oraz zaproponowanie takiej możliwości rodzinie i znajomym. W ten sposób można otrzymać jakiś "zwrot" za wakacje na które i tak by się pojechało.

-

-

- 7 odpowiedzi

Wybrany przez

mysc, -

-

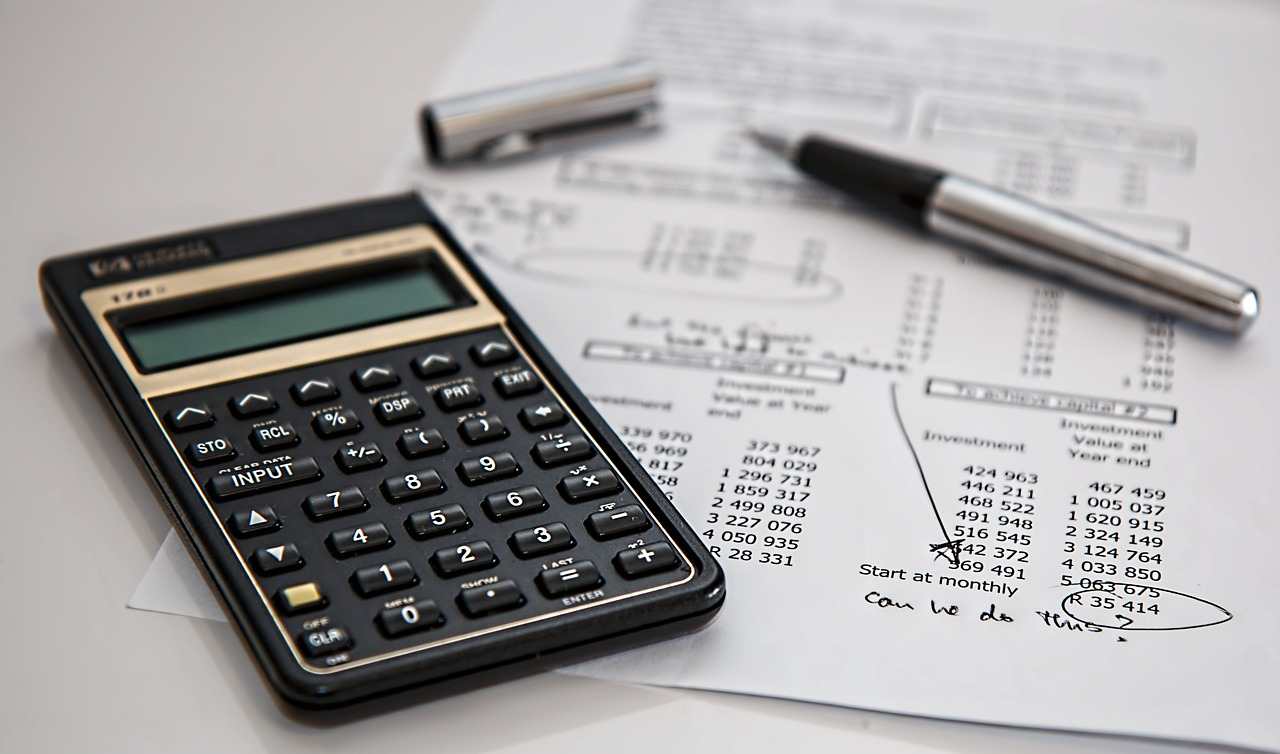

Poradnik podatkowy 2026 - jak rozliczać się z pieniędzy zarobionych przez Internet bez DG?

mysc opublikował(a) temat w Podatki, prawo, własna firma,

Zarabianie w Internecie wiąże się z koniecznością płacenia podatków - a rozliczanie się z urzędem skarbowym nie jest jednoznaczne i proste. Prawo podatkowe w Polsce jest nieujednolicone - co oznacza, że każdy urząd skarbowy może mieć inne interpretacje. Sprawdź jak się za to zabrać!-

-

- 36 odpowiedzi

Wybrany przez

mysc, -

-

![⭐️ [OFICJALNY MENTORING] Unikalne poradniki, skuteczne zarabianie online! Dostęp LIFETIME!](https://make-cash.pl/uploads/monthly_2018_05/Screenshot_1.png.9b02fafe5411acf95eedfdf3ed450ad3.png)

![[PORADNIK] Jak zacząć zarabiać na płatnych publikacjach artykułów sponsorowanych?](https://make-cash.pl/uploads/monthly_2025_05/student-849822_640.jpg.15df8a0c478f1203b2d665e1b20d8246.jpg)

Rekomendowane odpowiedzi

Jeśli chcesz dodać odpowiedź, zaloguj się lub zarejestruj nowe konto

Tylko zalogowani użytkownicy mogą dodawać komentarze.

Zarejestruj nowe konto

Załóż nowe konto. To bardzo proste!

Zarejestruj sięZaloguj się

Posiadasz już konto? Zaloguj się poniżej.

Zaloguj się