Znajdź zawartość

Wyświetlanie wyników dla tagów 'poradnik seo' .

Znaleziono 43 wyników

-

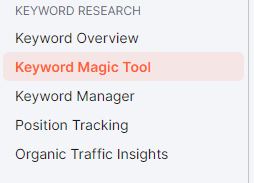

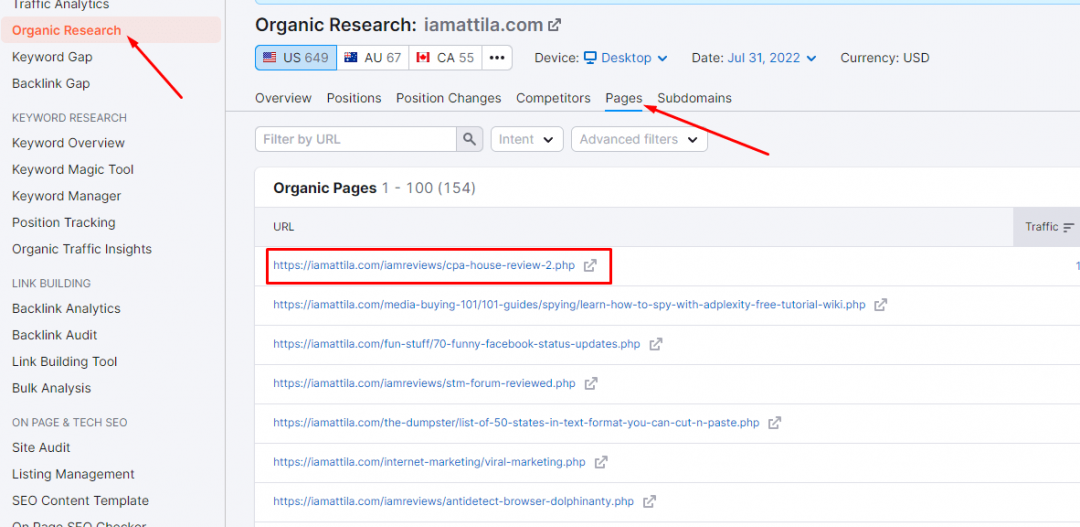

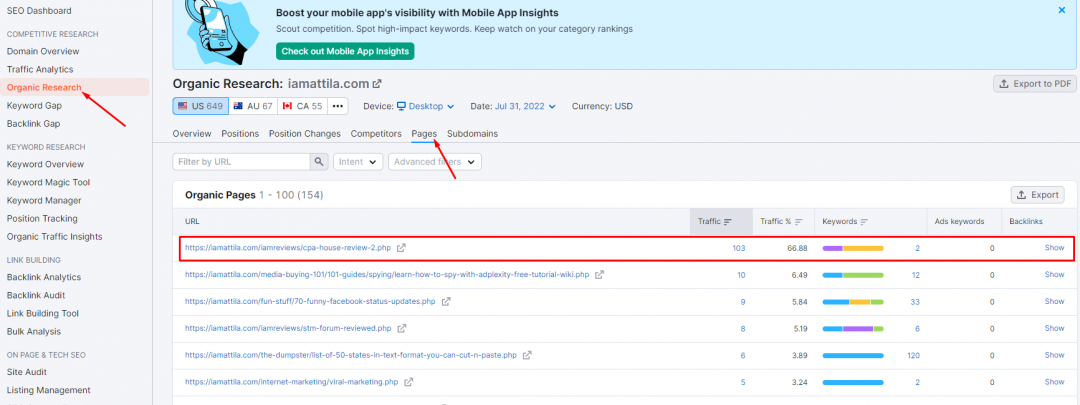

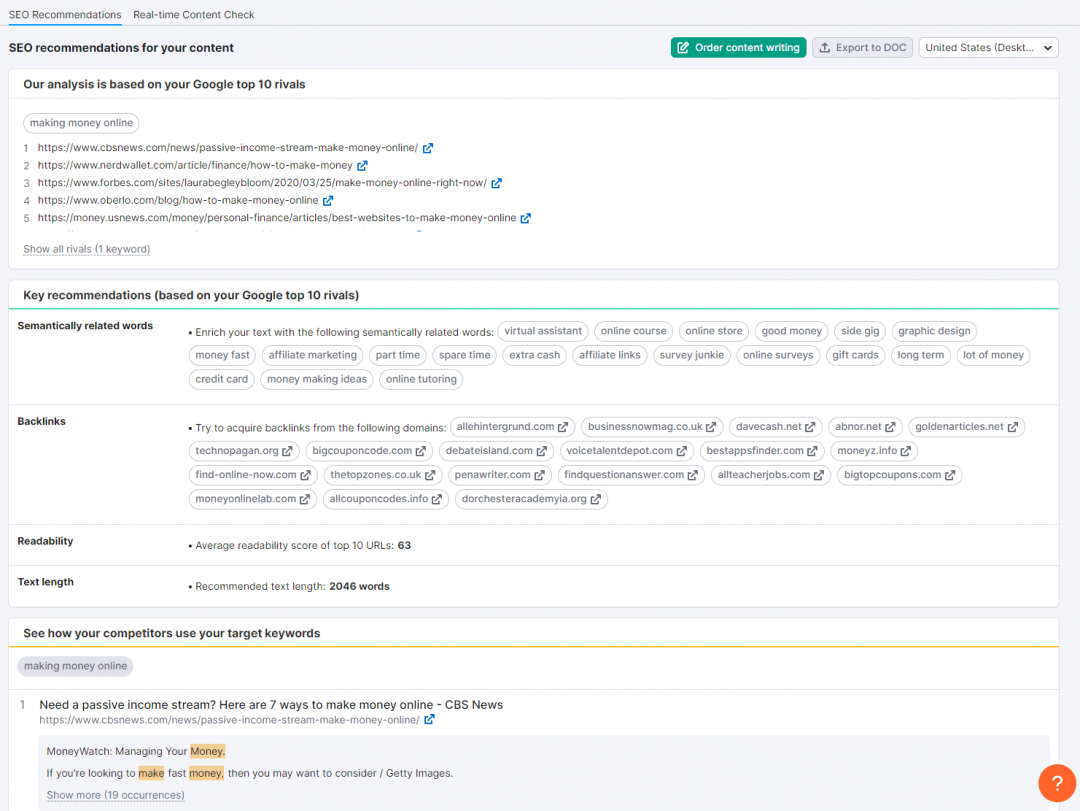

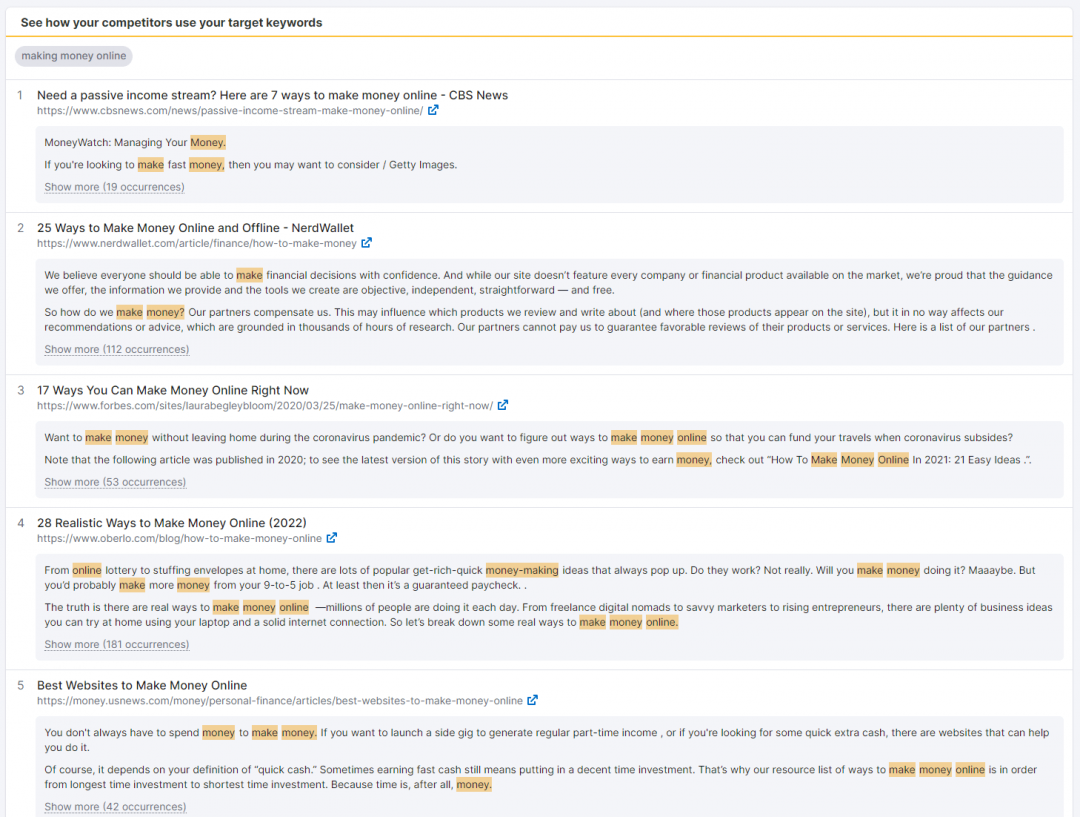

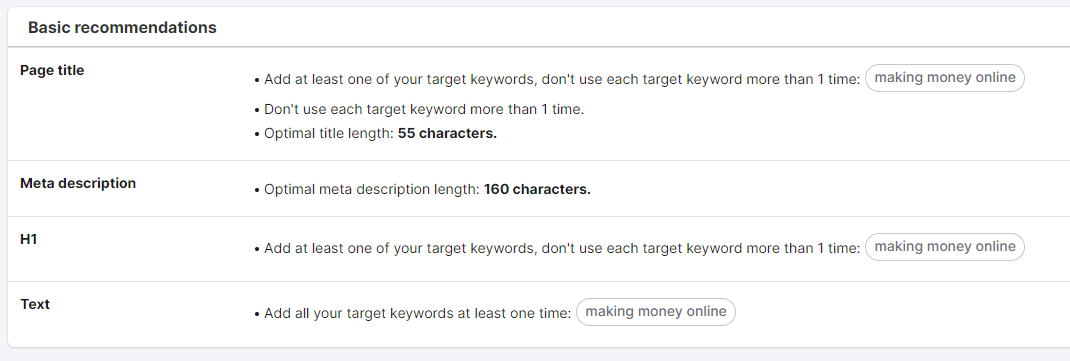

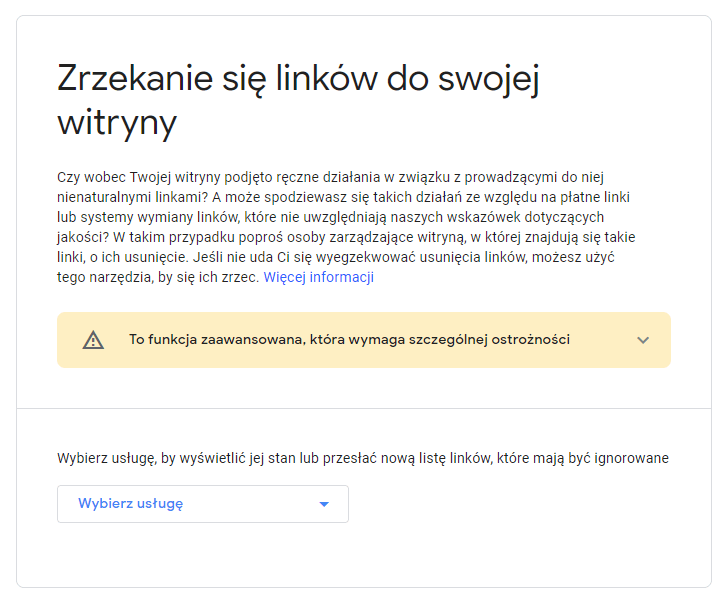

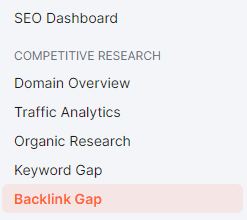

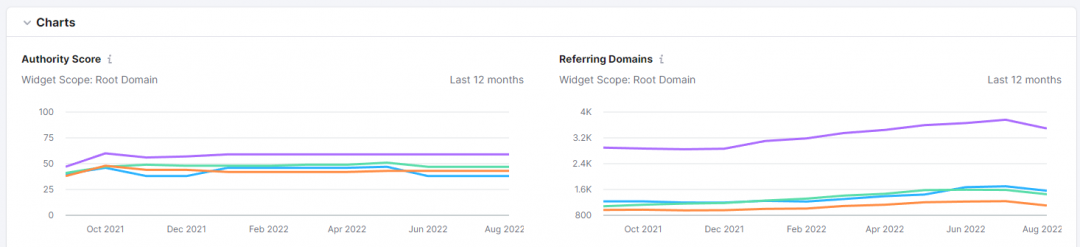

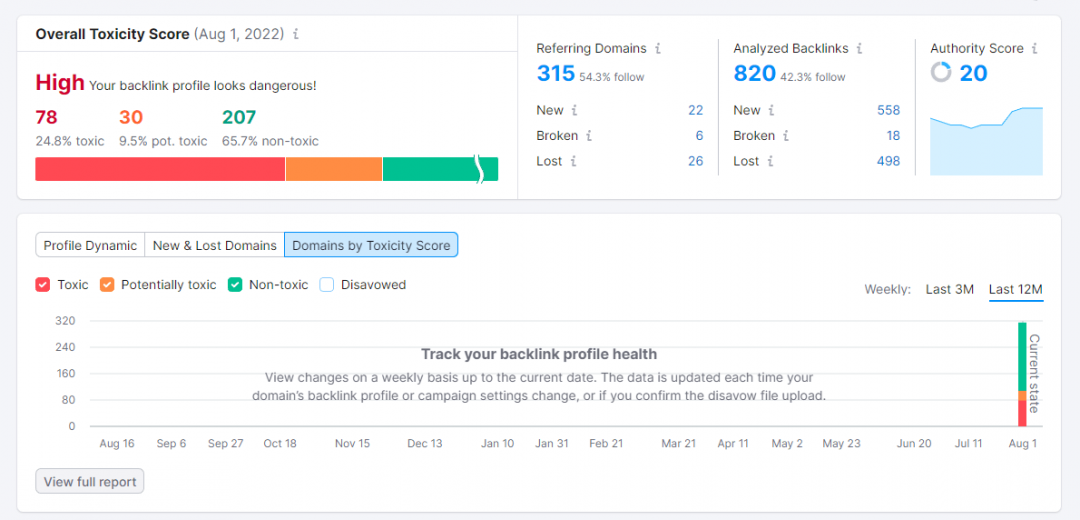

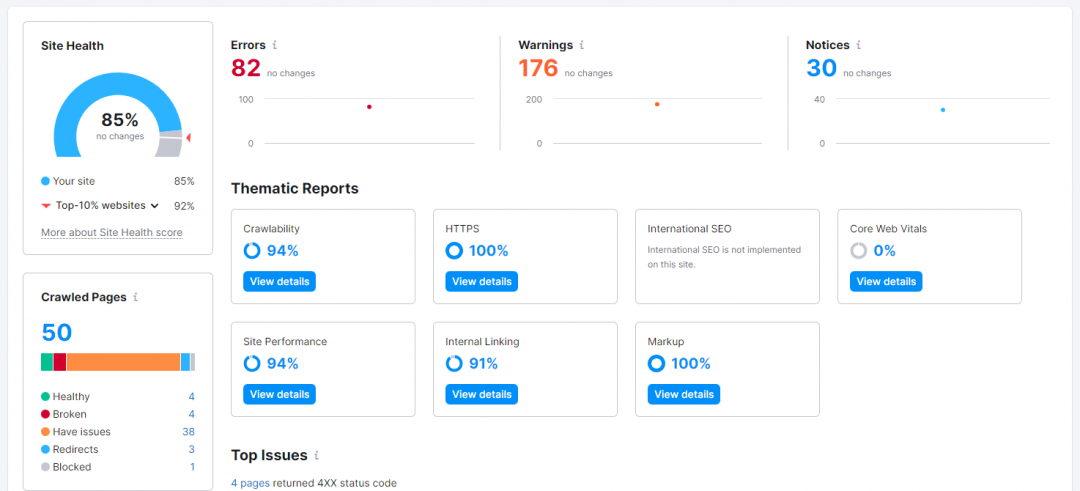

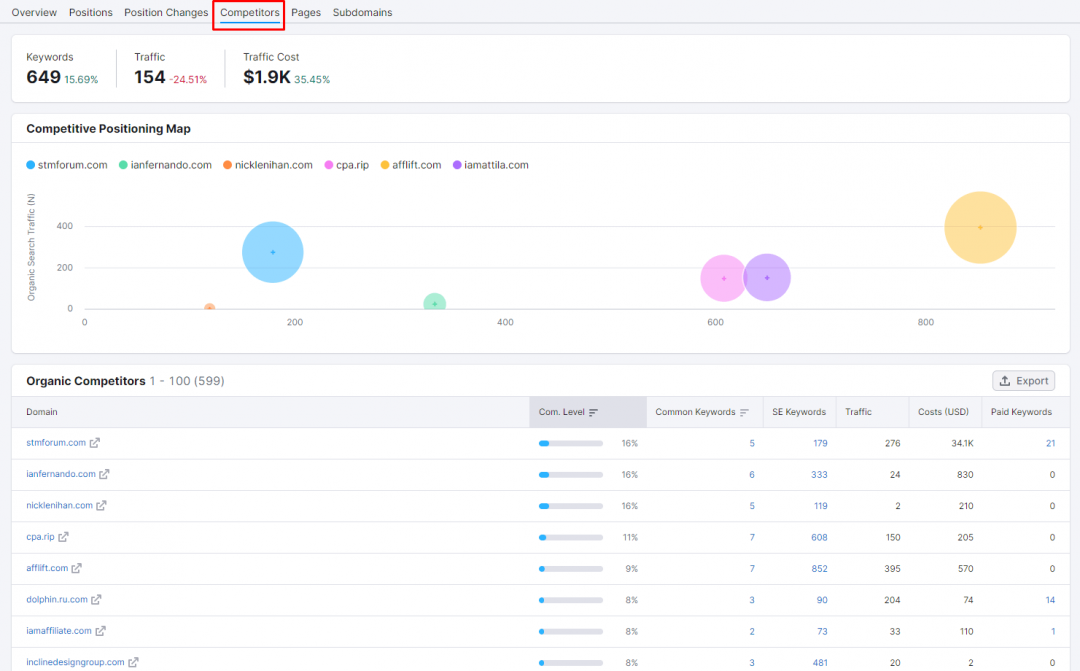

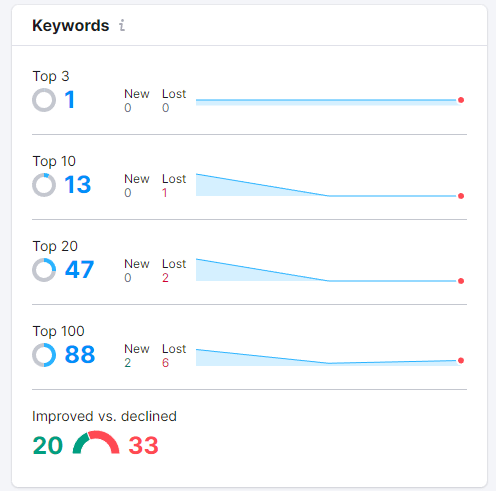

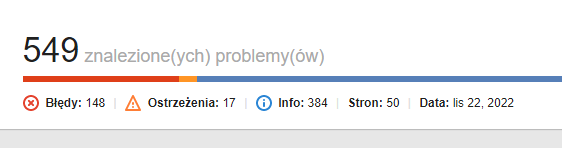

Istnieje kilka sposobów, by wykorzystać SEMRush, aby zwiększyć swój ruch na stronie WWW i wspomóc swoją pracę w zakresie SEO i content marketingu. Platforma ta jest pełna narzędzi i funkcji, które pomogą Ci zoptymalizować Twoją ogólną strategię marketingową.Nowi użytkownicy mogą czuć się przytłoczeni ich ilością i może być im ciężko określić od czego zacząć w Semrush. W związku z tym, oto 9 możliwych sposobów, jak możesz użyć SEMRush, aby napędzić ruch do swojej witryny i poprawić wyniki w SERPach. INFORMACJA: Jeśli nie stać Cię na subskrypcję premium w SEMRush, sprawdź forumowe SeoTools, na które na pewno będzie Cię stać 1. Wyszukiwanie słów kluczowych long-tail (z dużym potencjałem ruchu) Oto sekret sukcesu w SEO: badanie słów kluczowych. Znalezienie najbardziej dochodowych słów kluczowych dla Twojej witryny jest podstawą solidnej strategii SEO. Jeśli działasz w niszy, w której panuje silna konkurencja, trudno będzie Ci zdominować wyniki wyszukiwania, jeśli Twój content marketing jest zbudowany wokół słów kluczowych o dużej ilości wyszukań i wysokiej konkurencji. Jeśli dopiero zaczynasz, to strona z wyższym autorytetem prawie zawsze będzie cię prześcigać w SERPach. W związku z tym, zawsze powinieneś zacząć od słów kluczowych o niskiej konkurencji i dużym potencjale ruchu. To moment, w którym Keyword Magic Tool z SEMRush może być niezwykle przydatny. Keyword Magic Tool to łatwe w użyciu narzędzie do badania słów kluczowych, które zapewni Ci wszystkie keywordy, których potrzebujesz do zbudowania skutecznej kampanii SEO lub PPC. Dzięki temu narzędziu możesz wygenerować setki słów kluczowych long-tail dla swojego głównego słowa kluczowego (lub kilku słów kluczowych). Aby skorzystać z tego narzędzia, zaloguj się do Semrush i przejdź do: Keyword Research -> Keyword Magic Tool Wpisz swoje ogólne słowo kluczowe (lub słowa kluczowe) i naciśnij "Search". Z Twojego słowa kluczowego, narzędzie wygeneruje listę powiązanych słów kluczowych. Dla każdego z nich, narzędzie pokaże Ci kluczowe metryki, takie jak ilość wyszukań, trudność słowa kluczowego (KD), CPC i konkurencja. Ale ponieważ szukamy long-taili z niskim wolumenem wyszukiwania, ale wysokim potencjałem ruchu, będziemy musieli zawęzić naszą listę słów kluczowych do wybranych kilku. Po lewej stronie w wynikach, znajdziesz grupy słów kluczowych dla swojego głównego keyworda. Grupy te mogą pomóc Ci znaleźć kombinacje long-tail z dokładnie tymi samymi słowami kluczowymi, których szukają ludzie. Możesz wybrać dowolną z tych grup, aby znaleźć long-taile w każdej grupie. Te słowa kluczowe będą miały niski-średni wolumen wyszukiwania, ale mniejszą konkurencję, co oznacza, że łatwiej jest wyprzedzić konkurentów. Po zidentyfikowaniu słów kluczowych, które chcesz włączyć do swojej kampanii, możesz dodać te słowa kluczowe bezpośrednio do Keyword Analyzer, aby uzyskać bardziej szczegółowe informacje na ich temat. 2. Identyfikacja możliwości w zakresie treści poprzez znalezienie najlepiej działających podstron Twojego konkurenta Analiza konkurencji jest jednym z najważniejszych elementów udanej kampanii marketingowej. Uzbrojony w doświadczenia konkurencji, możesz poprawić i rozwinąć własną strategię marketingową. Semrush ma mnóstwo narzędzi i funkcji, które pozwalają uzyskać wgląd w strony internetowe konkurencji. Najpierw zidentyfikujmy najlepsze podstrony Twojego konkurenta - są to strony, które generują największy ruch. Wybierz Domain Overview z menu rozwijanego i wprowadź domenę swojego konkurenta. Na stronie z wynikami kliknij Organic Research, a następnie przejdź do Pages. Tutaj znajdziesz najlepsze podstrony Twojego konkurenta oraz procent ruchu organicznego, jaki generuje każda z nich. Oto najlepiej działająca strona IAmAttila - generuje ona największy procent ruchu organicznego na jego blogu: Po znalezieniu strony, którą chcesz targetować, możesz kliknąć na numer słowa kluczowego, aby odsłonić całkowitą liczbę słów kluczowych, dla których strona zajmuje miejsce w top 100 wyników wyszukiwania Google. Znajdowanie najlepszych podstron konkurencji może być bardzo przydatnym ćwiczeniem w tworzeniu własnej strategii contentowej. Możesz wziąć pomysły na słowa kluczowe, które już zadziałały u Twoich konkurentów i zacząć konstruować swoje treści w znacznie lepszy sposób niż oni. W ten sposób przyciągniesz również więcej backlinków niż konkurencja, co ostatecznie pozwoli Ci wyprzedzić ją w wynikach wyszukiwania. 3. Optymalizacja istniejących treści SEO Content Template jest niezbyt często wykorzystywanym narzędziem w Semrush. To narzędzie może pomóc w tworzeniu treści przyjaznych SEO, ukazując arkusz zaleceń na podstawie docelowych słów kluczowych. Te zalecenia są oparte na wglądzie w 10 najlepszych stron Google dla Twoich słów kluczowych. Aby zacząć, wybierz SEO Content Template z lewego menu nawigacyjnego. Wybierz ustawienia docelowe (kraj, język, typ urządzenia), wpisz słowo/słowa kluczowe, na których chcesz się wybić i kliknij przycisk Create SEO Template. Semrush wygeneruje wtedy szablon zaleceń SEO dla Twoich treści. Obejmują one sugestie dotyczące: Semantically related words - słowa lub frazy, które są ze sobą powiązane. Backlinks -domeny, które możesz targetować do pozyskania backlinków Readability- łatwość, z jaką czytelnik może zrozumieć Twoją treść. Text length - idealna liczba słów w treści. Skorzystaj z tych sugestii, aby ułożyć swoją treść w taki sposób, by wyprzedzić swoich rywali z pierwszej dziesiątki w SERPach. Użyj semantycznie powiązanych słów kluczowych, aby zapewnić sobie więcej kontekstu dla danego tematu, dzięki czemu mogą one wyżej pojawiać się w wynikach wyszukiwania. Sugerowana lista backlinków to domeny, które należy targetować w celu uzyskania backlinków. Są to backlinki zdobyte przez 10 najlepszych rywali w Google dla docelowych słów kluczowych, a jeśli chcesz ich wyprzedzić w wynikach wyszukiwania, musisz zdobyć jak najwięcej backlinków z listy wymienionych tutaj domen. Wynik czytelności Twojej treści jest miarą tego, jak łatwo jest ją przeczytać. Im wyższy wynik (im łatwiejsza jest lektura), tym bardziej dostępna jest ona dla docelowych odbiorców i tym większe szanse na dobre wyniki w SERPach. Użyj sugerowanej długości tekstu, aby zorientować się, jak długi powinien być Twój wpis na blogu. W większości przypadków Google preferuje treści długie, czyli takie, które wyczerpują temat. Przewiń stronę zaleceń w dół, aby zobaczyć 10 najlepszych konkurencyjnych artykułów w Google dla docelowych słów kluczowych. Kliknij na Show more poniżej każdego artykułu, aby zobaczyć pełny tekst. Możesz również zobaczyć docelowe słowa kluczowe użyte w treściach Twojej konkurencji. Te docelowe słowa kluczowe są zaznaczone na pomarańczowo. Przewiń dalej w dół, aby zobaczyć podstawowe zalecenia dotyczące docelowych słów kluczowych. Sugestie te oparte są na: Page Title - idealna długość tytułu i użycie docelowych słów kluczowych. Meta description - optymalna długość H1 - użycie docelowych słów kluczowych i ich częstotliwość Text - użycie docelowych słów kluczowych i ich częstotliwość Postępuj zgodnie z tymi kluczowymi i podstawowymi zaleceniami, aby zoptymalizować istniejące treści i mieć większe szanse na wyprzedzenie konkurencji w wynikach wyszukiwania. 4. Identyfikacja toksycznych backlinków i pozbycie się ich Oprócz pozyskiwania nowych backlinków należy pozbywać się backlinków, które przynoszą więcej szkody dla strony niż pożytku. Aby to zrobić, należy przesłać plik tekstowy zawierający toksyczne domeny do narzędzia Google Disavow Links Tool. Raport Disavow w narzędziu Backlink Audit w Semrush pomoże Ci przygotować plik zawierający wszystkie toksyczne backlinki, które chcesz usunąć ze swojej witryny. Backlink Audit jest narzędziem projektowym, więc aby uzyskać do niego dostęp, wybierz jeden ze swoich projektów i kliknij Set up pod Backlink Audit. Wybierz domenę główną z opcji i kliknij Start Backlink Audit. Na marginesie: Jeśli nie masz jeszcze pliku disavow, możesz go stworzyć, eksportując wszystkie linki, które przeniosłeś do zakładki Disavow w Semrush. Jeśli połączyłeś swoje konto Semrush z Google Search Console, możesz importować wszystkie listy disavow z Google Disavow Tool za pomocą jednego kliknięcia. Przejrzyj wszystkie toksyczne backlinki zanim je usuniesz. Upewnij się również, że usuwasz linki na poziomie domeny, a nie na poziomie adresu URL. Po przygotowaniu listy disavow należy kliknąć przycisk eksportu w celu pobrania odpowiednio sformatowanego pliku .txt z listą disavow. Jeśli nie zintegrowałeś swojego konta Semrush z Google Search Console, będziesz musiał ręcznie przesłać swój plik disavow do Google. Aby to zrobić, kliknij ten link i wybierz domenę, z której chcesz usuwać linki. Google przypomni ci, że jest to zaawansowana funkcja i że musisz postępować ostrożnie. Po uzyskaniu całkowitej pewności, że plik disavow zawiera wyłącznie toksyczne linki ze spamerskich stron internetowych, należy przesłać plik i wybrać opcję "prześlij". Najlepszą praktyką SEO jest przeglądanie backlinków raz w miesiącu oraz pozbywanie się linków, które szkodzą SEO witryny. 5. Identyfikacja nowych możliwości pozyskiwania backlinków Dzięki narzędziu Semrush Backlink Gap Tool można przeanalizować profile backlinków nawet pięciu konkurentów. Dane te mogą być następnie wykorzystane do identyfikacji niewykorzystanych możliwości link buildingu. Aby uzyskać dostęp do Backlink Gap Tool, przejdź do: Gap Analysis > Backlink Gap > wprowadź swoją domenę + 4 domeny swoich największych konkurentów. Po wprowadzeniu domen konkurentów, naciśnij zielony przycisk i pozwól, aby Semrush wypełnił dane za Ciebie. Narzędzie Backlink Gap zwróci wykres i tabelę przedstawiającą porównanie profili backlinków kilku domen. Można uzyskać szybki wgląd w to, który konkurent buduje najwięcej nowych backlinków dzięki wykresowi trendu na górze. Poniżej wykresu zobaczysz pełną listę domen odsyłających dla wszystkich domen. Teraz dochodzimy do najciekawszego aspektu tego narzędzia - przeglądania możliwości pozyskiwania backlinków, które nam umykają. Oznacza to, że musimy poszukać domen odsyłających, z których Twoi konkurenci mają linki, ale Twoja domena nie. Aby uzyskać te dane, wybierz swoją domenę w rozwijanym oknie nad tabelą. Te strony mogą być Twoimi następnymi celami link buildingu, ponieważ linkują do stron konkurencji, a do Twojej nie. SEO zasadniczo sprowadza się w sporej części do jednej rzeczy - ile masz autorytatywnych linków wskazujących na Twoją domenę. Dzięki narzędziu Backlink Gap od Semrush możesz mieć pewność, że jesteś o krok przed wszystkimi swoimi najlepszymi konkurentami. 6. Odzyskiwanie utraconych backlinków Wyobraź sobie, że wkładasz cały swój wysiłek i ciężką pracę w uzyskanie backlinków o wysokim autorytecie, a te znikają bez ostrzeżenia. Może to być naprawdę frustrujące. Na szczęście dzięki narzędziu takiemu jak Semrush można odzyskać utracone backlinki. Aby znaleźć utracone backlinki, należy przejść do: Competitive Research > Domain Overview > Wprowadź swoją domenę Na stronie wyników należy przejść do zakładki Backlinks, aby uzyskać szczegółowy wgląd w profil linków. Z tego miejsca należy wybrać "Lost" i dodać filtr "Follow" oraz posortować według wyniku Authority Score (AS) w kolejności malejącej. W ten sposób można znaleźć utracone backlinki z zaufanych domen o wysokim autorytecie. Zrób kampanię outreach, aby dotrzeć do właścicieli każdej z tych domen i spróbować odzyskać swoje backlinki. 7. Zidentyfikuj i napraw krytyczne błędy SEO, które szkodzą Twoim wynikom w SERPach Narzędzie Site Audit od Semrush to potężne narzędzie. Nie tylko pomoże Ci zidentyfikować techniczne problemy SEO Twojej witryny, ale także wskaże kroki i zalecenia, aby szybko naprawić te krytyczne błędy. Aby przeprowadzić audyt witryny, zaloguj się do Semrush i przejdź do: Projects > Create Project > Wprowadź swoją domenę. Następnie kliknij przycisk Set up pod Site Audit, aby otworzyć nowe okno ustawień. Wprowadź tutaj wszystkie szczegóły i kliknij Start Site Audit. Poczekaj kilka sekund, podczas gdy Semrush crawluje Twoją witrynę i generuje raport na temat wszystkich błędów, które musisz naprawić, aby uzyskać lepsze wyniki. Całkowity wynik witryny jest oparty na stosunku znalezionych problemów do liczby wykonanych kontroli. Problemy techniczne w Twojej witrynie są zorganizowane w 3 kategorie: Błędy (pokazane na czerwono) - Są to problemy, które mają najwyższą wagę i dlatego powinny być naprawione natychmiast. Błędy te mogą dotyczyć zerwanych linków na stronie, błędów sitemap, błędów robots.txt, problemów z duplicate content, itp. Ostrzeżenia (pokazane na pomarańczowo) - Te problemy mają średnią wagę. Przykłady obejmują zduplikowane znaczniki title i H1, obrazy, które nie zawierają atrybutów alt, linki wewnętrzne, które zawierają atrybuty nofollow, brakujące opisy meta itp. Uwagi (pokazane na niebiesko) - Są to drobne problemy. Przykłady obejmują linki zewnętrzne, które zawierają atrybuty nofollow, strony zablokowane przed indeksowaniem, osierocone strony w sitemapach itp. Poniżej błędów, ostrzeżeń i powiadomień, zobaczysz 3 największe problemy z audytu. Kliknij na dowolny z tych problemów, aby zobaczyć listę przedstawioną w zakładce Issues. W zakładce Issues zobaczysz szczegółowe wyjaśnienie wszystkich problemów oraz kroki, które musisz podjąć, aby je naprawić. Błędy będą miały większy wpływ na Twój całkowity wynik niż ostrzeżenia, ale obie te rzeczy powinny zostać wzięte pod uwagę, aby poprawić zdrowie Twojej witryny. Więc uruchom audyt witryny co tydzień i napraw wszelkie problemy, jeśli takowe się pojawią. Wynik 85% lub wyższy powinien wskazywać, że nie ma żadnych technicznych problemów SEO z Twoją stroną. 8. Identyfikacja głównych konkurentów Aby wyprzedzić swoją konkurencję w wynikach wyszukiwania, musisz dowiedzieć się, z kim masz do czynienia. Są to konkurencyjne domeny, które dzielą przestrzeń w wyszukiwarce z Twoją domeną dla wszystkich ważnych słów kluczowych w Twojej niszy. Aby zidentyfikować swoich konkurentów, przejdź do: Competitive research > Organic Research > Wpisz swoją domenę. W tym przykładzie wpisałem stronę I Am Attila jako domenę i znalazłem te wyniki w zakładce Competitors: Kliknij zakładkę Competitors, aby zobaczyć listę domen, z którymi Twoja witryna konkuruje w top 20 organicznych wyników wyszukiwania Google. Domeny zostaną posortowane według poziomu konkurencji, który jest oparty na analizie liczby słów kluczowych, które dwie domeny wspólnie wykorzystują. Możesz również wyeksportować listę konkurencji, klikając przycisk eksportu w prawym górnym rogu listy. 9. Śledzenie pozycji słów kluczowych Twojej strony w SERPach Jednym ze sposobów, aby zawsze pozostać na szczycie w SERPach, jest śledzenie pozycji w wyszukiwarkach dla najważniejszych słów kluczowych. W Semrush możesz śledzić swoje słowa kluczowe za pomocą narzędzia Position Tracking. To narzędzie pozwala dodać wszystkie słowa kluczowe, dla których chcesz uplasować się w wynikach wyszukiwania i śledzić pozycje tych słów kluczowych dla dowolnej lokalizacji na wielu urządzeniach. To narzędzie pozwala na dodanie listy słów kluczowych, które chcesz uszeregować i śledzić ich dzienny/tygodniowy postęp w SERPach dla dowolnej lokalizacji na wielu urządzeniach. Aby rozpocząć śledzenie słów kluczowych, przejdź do: Projects > Position Tracking > Set up. Dodaj lokalizację, wybierz urządzenie (desktop, mobile lub tablet), dodaj domeny konkurentów, a następnie na koniec dodaj listę słów kluczowych, dla których chcesz uzyskać ranking. Nie przejmuj się, jeśli pominiesz kilka słów kluczowych. Zawsze możesz je dodać później. Raport pokazuje trzy główne wskaźniki dla każdego z dodanych słów kluczowych: pozycje, szacowany ruch i widoczność.

- 3 odpowiedzi

-

- seo

- poradnik seo

-

(i 4 więcej)

Oznaczone tagami:

-

Czy ktoś ma dobry "poradnik" do pozycjonowania wizytówki google?

KitKet opublikował(a) temat w Rozmowy o SEO

Hej, mam pytanie, czy ktoś ma jakieś "info" poważniejsze jak pozycjonować swoją wizytówkę google w 2024 roku? Dodałem swoją wizytówkę do wielu katalogów firm, z mapkami, bez itp, również do swojego małego zaplecza seo, ale nadal ciężko to idzie. Wizytówkę optymalizuje - więcej słów kluczowych, więcej zdjęć. Oczywiście problem z opiniami jest bo tak na prawdę każdy w mojej branży ma gdzieś opinie googla. Przynajmniej tak zauważyłem.- 1 odpowiedź

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

Jak pisać treści na stronę internetową z wykorzystaniem AI

Wujek Ziemny opublikował(a) temat w Case Study i Poradniki SEO

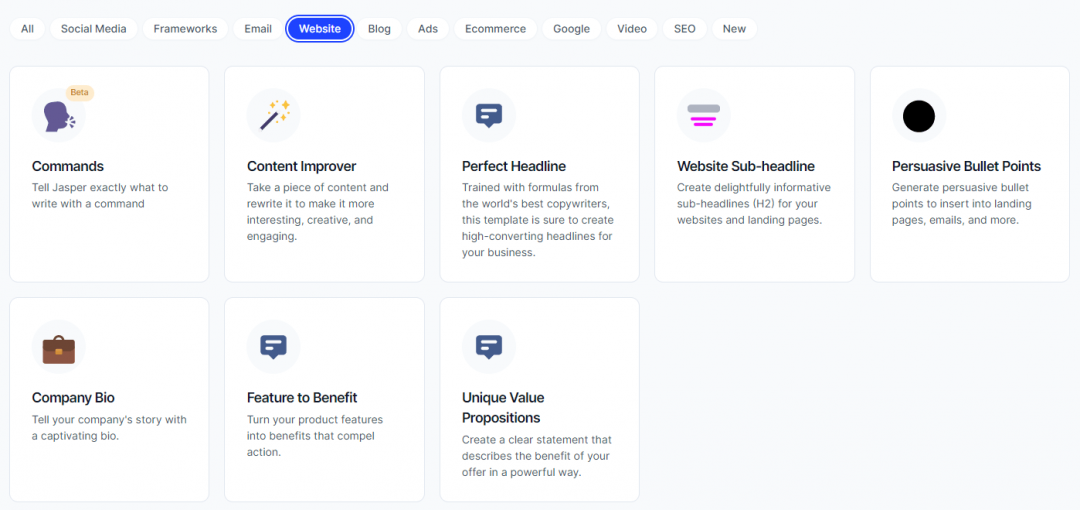

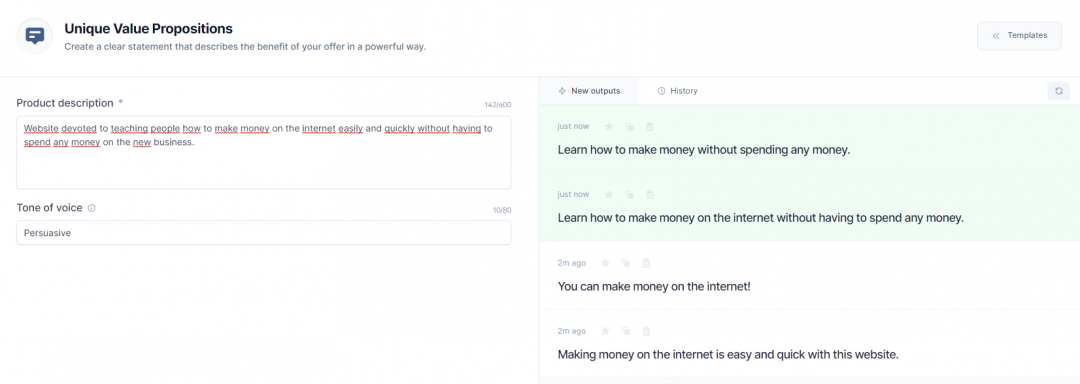

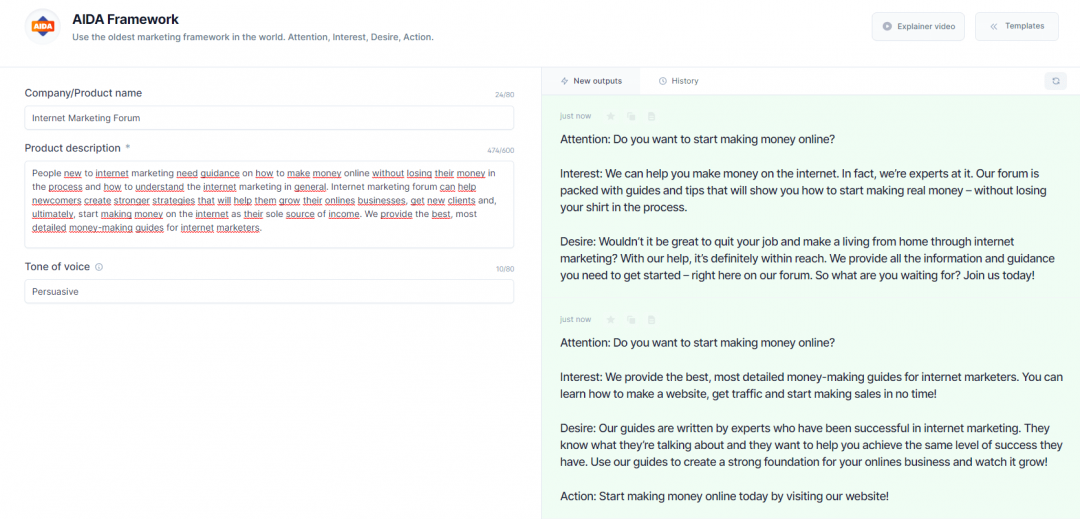

Wysokiej jakości treści na stronie internetowej przyciągają uwagę docelowych odbiorców i sprawiają, że strona jest zapamiętywana, pomaga zdobywać leady i sprawia, że odbiorcy wracają po więcej. Tworzenie treści od podstaw może być procesem czasochłonnym. Istnieje wiele mniejszych kroków, o których należy pomyśleć w drodze do stworzenia atrakcyjnych treści, takich jak badanie rynku, SEO i redagowanie tekstu, a to tylko początek. Jednak nie musisz zaczynać od zera, gdy istnieją narzędzia AI, które mogą pomóc w tworzeniu wysokiej jakości treści. Spis treści Jak napisać artykuł na stronę internetową w sześciu krokach 1. Określ główny cel swojej strony internetowej 2. Określ swoich idealnych odbiorców 3. Określ potrzeby klienta 4. Wprowadź badania słów kluczowych 5. Pisz, optymalizuj i redaguj 6. Opublikuj swój artykuł i aktualizuj go na bieżąco Jak pisać treści na strony internetowe z wykorzystaniem AI Przykładowe pisanie treści na stronę internetową z wykorzystaniem szablonu AIDA Pisz szybciej z Jasper Poniżej przejdziemy przez sześć kroków, które musisz podjąć, aby mieć pewność, że treści na Twojej stronie są tak dobre, jak to tylko możliwe. Pokażemy Ci również, w jaki sposób możesz szybciej zdobywać treści bez utraty jakości. Jak napisać artykuł na stronę internetową w sześciu krokach Niezależnie od tego, czy tworzysz nową treść strony internetowej od podstaw, czy też odświeżasz istniejącą, jest kilka kluczowych rzeczy, o których należy pamiętać. Do tej pory dowiedziałeś się już, jak ważne jest, aby pisać jasno, pisać z minimalną ilością błędów i pisać w języku, który przemawia do grupy docelowej. Jednak co nam po dobrze napisanym artykule, jeśli nikt go nie przeczyta? W tym miejscu będziesz chciał również rozważyć SEO jako część strategii dla treści Twojej witryny. Ale więcej na ten temat później. Zanurzmy się głębiej w każdy etap procesu pisania artykułów wraz z poradami i przykładami 1. Określ główny cel swojej strony internetowej Choć może się to wydawać oczywistym krokiem, to właśnie od niego chcesz zacząć. Co wyniknie z tworzenia strony internetowej bez określenia głównego celu jej istnienia? Rozpoczynając tworzenie najbardziej atrakcyjnych treści dla landing page'y, stron kontaktowych i wszelkich innych stron, które planujesz opublikować, rozważ główny cel każdej z nich. Czy ma ona na celu: Sprzedać Twój produkt? Informować użytkowników o konkretnym temacie? Nakreślić przegląd opcji produktowych w konkretnej branży? Nauczyć użytkowników jak coś zrobić? A może kombinacja wszystkich czterech? Nie ma reguły, co do tego, jaki powinien być główny cel istnienia Twojej strony. Jednak im dokładniej określony jest główny cel powstawania Twojej witryny, tym większe prawdopodobieństwo, że osiągniesz swoje zamierzenia. 2. Określ swoich idealnych odbiorców Dla kogo piszesz? To w zasadzie pierwsze pytanie, które warto sobie zadać, zastanawiając się nad najlepszym sposobem podejścia do pisania. Jest to prawda niezależnie od tego, czy piszesz pod stronę sprzedażową, landing page, czy nawet stronę o sobie. Każdy fragment treści na Twojej stronie powinien być tworzony z myślą o odbiorcach. Badanie swojej idealnej grupy odbiorców można przeprowadzić na kilka sposobów. Niektóre z nich obejmują: Ankietowanie swojej listy e-mailowej, jeśli taką posiadasz Rozmowy z obecnymi klientami jeden na jeden Ocena tego, czym interesują się Twoi odbiorcy w mediach społecznościowych Używanie narzędzi SEO, takich jak SEMRush, aby uzyskać pomysł na to, czego szukają Twoi odbiorcy SemRush wydaje Ci się za drogi? Skorzystaj z SeoTools i uzyskaj dostęp do dziesiątek narzędzi za ułamek ich ceny! Weźmy stronę Gusto jako przykład marki SaaS w przestrzeni finansowej, która wie, jak tworzyć artykuły, które przemawiają do grupy docelowej (właściciele małych firm potrzebujący oprogramowania do płac). Wiedzą, jak napisać tekst, który odpowiada na najbardziej palące problemy ich klientów. 3. Określ potrzeby klienta Teraz, gdy już wiesz, kim jest Twoja grupa docelowa, kolejnym krokiem jest określenie potrzeb klienta. Dlaczego jest to konieczne? Zapoznanie się z tym, czego i dlaczego szukają Twoi odbiorcy jest niezbędną częścią copywritingu. Na przykład, proces odkrywania potrzeb klientów może odkryć problemy, na które odpowiedzi szukają Twoi odbiorcy w różnych zapytaniach wpisywanych w wyszukiwarki. Ta informacja pomaga dopracować treść strony internetowej. Intencje wyszukiwania dzielą się na cztery ogólne kategorie: Transakcyjny: Kiedy intencja wyszukiwania jest transakcyjna, użytkownicy są zazwyczaj w trybie "kupowania". Szukają konkretnego produktu, który zaspokoi ich potrzeby. Wszelkie zapytania zawierające słowa: kupno, transakcja, kupon lub nawet zniżka mogą być uznane za transakcyjne. Do wyszukiwań transakcyjnych należą również zapytania o konkretne nazwy produktów. Komercyjny: Kiedy użytkownicy wciąż próbują podjąć potencjalną decyzję o zakupie, ich zapytania do wyszukiwarki są uważane za komercyjne. Posty porównawcze lub recenzje są często pisane w celu zaspokojenia potrzeb o charakterze komercyjnym. Listy mogą być skutecznym sposobem na uszeregowanie treści przeznaczonych dla słów kluczowych o intencji handlowej. Nawigacyjny: Słowa kluczowe z intencją nawigacyjną są wyszukiwane, gdy użytkownik próbuje dotrzeć do konkretnego miejsca docelowego, takiego jak witryna konkretnej marki lub konkretna strona internetowa. Jeśli ktoś szuka "Groupon" w Google, to jest to przykład intencji nawigacyjnej. Informacyjny: Wyszukiwane hasła z intencją informacyjną, takie jak "meksykańska restauracja w mojej okolicy" lub "jak założyć stronę internetową od podstaw" oznacza, że użytkownicy szukają odpowiedzi na pytanie lub chcą dowiedzieć się więcej na określony temat. 4. Wprowadź badania słów kluczowych Sama dobra treść nie wystarczy, aby przyciągnąć ruch do Twojej witryny. Badania słów kluczowych i intencji wyszukiwania powinny nie tylko dać Ci informacje o tym, co powinieneś napisać, ale także pomóc Ci określić, jak powinieneś to robić. Na przykład, jeśli piszesz o strategii mediów społecznościowych i badania ujawniają, że publiczność szuka "najlepszego harmonogramu mediów społecznościowych", słowo "najlepszy" wskazuje na intencję kupującego. Jeśli Twoja strona jest o mediach społecznościowych, najlepiej jest włączyć treść, która mówi o najlepszym oprogramowaniu planowania mediów społecznych. W ten sposób odpowiesz na ich zapytanie i miejmy nadzieję, że uplasujesz się wyżej w SERPach. Rozważ użycie takich narzędzi jak: Ubersuggest Google Keyword Planner SemRush Pomogą Ci one zorientować się, czego szukają odbiorcy i jak często. Stamtąd możesz rozpocząć proces tworzenia konspektu i zacząć ożywiać swoje pisanie z perspektywy informacji. Na temat potencjalnych możliwości serwisu SemRush przeczytasz tutaj: 5. Pisz, optymalizuj i redaguj Mając za podstawę badania, intencje odbiorców i jasno określony cel istnienia strony, czas zacząć tworzyć jej treść. Oto kilka wskazówek dotyczących pisania, o których warto pamiętać: Pisanie: Pisanie artykułów na stronę internetową rozpoczyna się od opracowania treści dla głównych stron. Może to być strona główna, strona o nas czy strona kontaktowa. Po wszystkich badaniach, napisanie artykułu, który przemawia do odbiorców powinno być znacznie łatwiejsze zadaniem. Będziesz w stanie napisać nagłówki, a nawet CTA, które odpowiadają na pytania odbiorców. Chcesz mieć pewność, że piszesz jak najbardziej bezpośrednio do odwiedzających Twoją stronę. To wymaga pewnych umiejętności. Ale rozpoczęcie od jasnego podtytułu, silnego CTA i odpowiednia korekta pomagają. Optymalizacja: Nie zapomnij wykorzystać wszystkich informacji, które zdobyłeś. Włączaj swoje główne słowa kluczowe wszędzie tam, gdzie jest to istotne. W ten sposób Google może prawidłowo zaindeksować to, o czym jest Twoja strona i może pokazać ją dla odpowiednich zapytań w wynikach wyszukiwania. Redagowanie: W końcu przyszedł czas na redagowanie. Strona internetowa ze zbyt wieloma błędami gramatycznymi i błędami formatowania może być natychmiastowo odrzucona przez użytkowników. Podniesienie jakości poprzez przejście przez kilka rund edycji robi różnicę i pomaga utrzymać wysoki poziom jakości, który mówi sam za siebie. 6. Opublikuj swój artykuł i aktualizuj go na bieżąco Po stworzeniu dopracowanej treści, pozostaje tylko nacisnąć przycisk "opublikuj". Jednak proces pisania nie kończy się na tym. Treści pisane w Internecie nieuchronnie się starzeją. Nawet treści, które mogą być uznane za "evergreen". Dlatego ostatnią częścią procesu pisania treści na stronie internetowej jest okazjonalne aktualizowanie artykułów. Z biegiem czasu, problemy Twoich odbiorców mogą się zmienić lub główny cel Twojej strony internetowej może ewoluować, stąd potrzeba okazjonalnych poprawek. Kiedy wracasz do odświeżania swoich opublikowanych treści, pamiętaj, aby wziąć pod uwagę zarówno strukturę, jak i SEO. Jak pisać treści na strony internetowe z wykorzystaniem AI Wiadomo, że pisanie treści, czy to na strony internetowe, czy na wpisy na blogu, może być ręcznym, czasochłonnym procesem. Ale istnieje szybszy sposób tworzenia treści bez utraty jakości. Wypróbuj Jasper, czyli asystenta pisania AI dla prawie każdego rodzaju treści. Dzięki niemu można skrócić czas, jaki poświęcasz na tworzenie treści, o połowę lub więcej. Pisanie oryginalnych tekstów może być proste i polegać jedynie na: Wprowadzaniu tytułu Dodaniu opisu Wpisaniu preferowanych słów kluczowych Wyborze języka i tonu wypowiedzi Jasper zawiera mnóstwo szablonów zaprojektowanych, aby pomóc Ci zdobyć przewagę w wysiłkach związanych z pisaniem tekstów na strony internetowe, w tym: Poprawiacz treści Generator doskonałych nagłówków Generator podtytułów stron internetowych Perswazyjne listy Bio firmy Więcej informacji oraz naszą opinię na temat Jasper znajdziesz tutaj: Podobne funkcje oferuje również konkurent Jasper - Rytr, który również może Ci się przydać! Przejdźmy przez jakiś przykład razem. Powiedzmy, że chcemy stworzyć stronę docelową dla najlepszego forum o zarabianiu przez internet. Użyjemy szablonu Unique Value Proposition, aby stworzyć przyciągające uwagę oświadczenie strony docelowej. W pierwszej kolejności będziemy chcieli: Zalogować się na nasze konto w Jasperze Kliknąć na Szablony Kliknąć na Unique Value Proposition Wprowadzić opis produktu (o czym jest Twoja strona) Wprowadzić preferowany ton Kliknąć Generate AI content Teraz czas na najlepszą część, czyli nasze wyniki. Po kliknięciu Generate AI content, Jasper robi resztę za Ciebie tak, jakby był ekspertem w temacie. Każde zdanie, które Ci się nie podoba, może zostać przepisane na nowo lub sprawdzone pod kątem ortografii lub gramatyki. Przykładowe pisanie treści na stronę internetową z wykorzystaniem szablonu AIDA AIDA, które oznaczaja Attention (uwaga), Interest (zainteresowanie), Desire (pożądanie) i Action (działanie), to skuteczny sposób na stworzenie treści dlastrony internetowej, która dotyka każdego punktu podróży kupującego przez lejek sprzedażowy. Na szczęście nie musisz zaczynać od zera, ponieważ Jasper udostępnia szablon AIDA, dzięki któremu możesz tworzyć treści za pomocą jednego kliknięcia. Aby rozpocząć tworzenie treści witryny za pomocą szablonu AIDA, wykonaj poniższe kroki: Zaloguj się na nasze konto w Jasper Kliknij na Templates Kliknij na AIDA Framework Wprowadź swój opis Wprowadź preferowany ton Wprowadź preferowany język Kliknij Generate AI content Pisz szybciej z Jasper Jako asystent pisania AI, Jasper może być kluczową częścią procesu pisania treści, gdy próbujesz strategicznie rozwijać stronę internetową. Dzięki niemu możesz przeznaczyć swoje zasoby - w tym czas i pieniądze - na inne zadania, które pozwolą Ci osiągnąć sukces. Ale najpierw ważne jest, aby zaplanować proces pisania, który pozwoli Ci produkować treści szybciej i lepiej. Bez wątpienia, asystent pisania AI jest potężnym narzędziem, które można włączyć do procesu. Wypróbuj Jasper za darmo i zobacz jak szybko możesz tworzyć treści na swoją stronę Ponadto, w sieci istnieją konkurencyjne serwisy, jak np. Rytr czy Article Forge, które również warto wziąć pod uwagę. Przeczytasz o nich tutaj: Artykuł przetłumaczony ze strony jasper.ai za pieniądze z reklam.- 13 odpowiedzi

-

- seo

- poradnik seo

- (i 8 więcej)

-

Poradnik Podstawowa optymalizacja Wordpressa pod kątem SEO

Termik opublikował(a) temat w Case Study i Poradniki SEO

Dzisiaj podrzucam Wam co zrobić po zapełnieniu naszego bloga postawionego na Wordpressie jakimś contentem (zawartością) - musimy go zoptymalizować. W tym artykule, przygotowanym przez SeoPilot.pl, możecie poznać podstawowe metody optymalizacji tej platformy pod kątem SEO. Artykuł pochodzi z: https://www.seopilot.pl/subscribe/1.html Optymalizacja serwisów na platformie WordPress Blogi utworzone na platformie WordPress cieszą się dużą popularnością na całym świecie. Jest to spowodowane tym, że WordPress za darmo udostępnia system, który jest prosty w konfiguracji, ma wygodny interfejs, harmonijny wygląd i posiada mnóstwo przydatnych pluginów. Jednakże podczas tworzenia blogu zapomina się o tak istotnej kwestii, jaką jest przygotowanie go do wypozycjonowania w wynikach wyszukiwania Google. W konsekwencji prowadzi to do problemów z zajęciem wysokich pozycji, a tym samym, do utraty potencjalnych czytelników i nadziei na sukces w blogosferze. Aby uniknąć problemów przy pozycjonowaniu bloga, należy przeprowadzić szereg zabiegów mających na celu jego wewnętrzną optymalizację i usunięcie przeszkód, które mogą wyniknąć w rezultacie niewłaściwej pracy zainstalowanych pluginów. Przyjrzyjmy się podstawowym zasadom, których zastosowanie pomoże rozwiązać najczęstsze problemy związane z SEO dla serwisów WordPress. Określenie podstawowej wersji strony Nazwa domenowa serwisu może być zapisana na dwa sposoby: z prefiksem www i bez niego. Z punktu widzenia wyszukiwarki to dwie różne strony, która próbuje je ze sobą skleić i zostawić w wynikach tylko jedną z nich. Aby nie dopuścić w procesie pozycjonowania do automatycznego połączenia i w rezulatcie utraty linków prowadzących na jedną z nich, koniecznie należy podczas tworzenia bloga wskazać wersję domyślną i na nią ustawić przekierowanie 301 z drugiej wersji. Te wskazania zawiera się w plikach .htaccess i Robots.txt, a także w zakładce dla Webmastera Google. Optymalizacja struktury URL Dla bloga na WP, jak i dla dowolnego innego serwisu, ważnym czynnikiem na drodze do skutecznego wypozycjonowania jest struktura URL podstron. Uważa się, że wyszukiwarki, tak jak i użytkownicy, lepiej odnoszą się do zrozumiałych adresów, tzw. przyjaznych URL. WordPress domyślnie generuje nieatrakcyjne URLe, np. somesite.com/?p=123. Aby doprowadzić URLe do porządku, aby zawierały słowo kluczowe, należy w panelu admistratora w ustawieniach przejść do zakładki PERMALINKS i wybrać jeden z dwóch sposobów zmiany struktury URLi: POST NAME (tytuł posta) lub CUSTOM STRUCTURE (dowolna struktura), przy czym do tworzonych adresów nie zapomnijcie dopisać końcówkę .html, ponieważ WP nie robi tego automatycznie. Ważna uwaga: jeśli zmieniacie strukturę URL na stronach już zaindeksowanych przez wyszukiwarkę, w celu uniknięcia utraty ruchu należy pamiętać, aby ustawić przekierowanie 301 z postów o starej strukturze adresu na ten sam post pod nowym adresem. Narzędzia - plik .htaccess albo plugin Change Permalink Helper. Wykorzystanie tagów H1 i H2. Określając indywidualne szablony dla WP często pojawiają się błędy związane z użyciem znaczników nagłówków. Właściwa optymalizacja strony zakłada tylko jedno użycie nagłówka H1, który wskazuje wyszukiwarce relewantność strony dla tego czy innego zapytania. w blogach na WP często spotykany jest jeden tytułowy H1 w nagłówku strony i kolejny w tytule posta. Można to zmienić przy pomocy tagów warunkowych. Rezultatem takiego zabiegu powinna być następująca struktura: H1 w nagłówku strony tylko na stronie głównej; H1 w tytule postów na podstronach; H1 w nagłówku kategorii i znacznika w archiwum; H2 w w tytule postów w liście na wszystkich stronach blogu. Sprawdzenie szybkości ładowania się stron Niemniej istotnym czynnikiem decydującym o sukcesie serwisu jest szybkość ładowania się stron. Powolne ładowanie negatywnie wpływa na zachowanie odwiedzających stronę i tym samym na pozycję strony w rankingu Google. Skorzystajcie z ogólnodostępnych narzędzi do sprawdzania szybkości strony. Jeśli wyjdą na jaw jakieś problemy, przeanalizujcie stronę pod kątem elementów, które mogą ją spowalniać. Wykorzystanie wtyczek SEO Za podstawową wtyczkę SEO dla blogów na WP uznaje się SEO by Yoast. W jednym pakiecie otrzymujecie wszystkie niezbędne instrumenty dla optymalizacji: sterowanie indeksacją, dodanie “okruszków chleba”, mapy serwisu, zapełnianie znaczników Title, Keywords, Descriptions i inne. W celu zwiększenia tempa ładowania się stron można posłużyć się pluginem W3 Total Cache i plugin Better WordPress Minify. Stworzenie rozszerzonego snippetu Dla pozycjonujących się w Google, bardzo przydatnym narzędziem będzie wtyczka Schema Creator. Przy jego pomocy można dodać mikrodane schema.org do waszych postów, aby stworzyć rozszerzony snippet w wynikach Google. Niewątpliwie poprawi to klikalność waszego posta. Istnieje możliwość wskazania autora, rankingu, składu, towaru, wydarzenia, filmu i innych danych. Odświeżenie treści Istnienie bloga nie jest do pomyślenia bez autorskich treści. Oprócz tego publikacje powinny być tematyczne, unikalne, interesujące dla czytelników i zawierać optymalną ilość słów kluczowych. Pamiętajcie także, że ważną rolę odgrywa regularne uaktualnianie treści. Nie należy zapominać o formatowaniu: akapity, podtytuły, grafika, pozytywnie wpływają na lepszy odbiór tekstu i pozytywnie wpływają na SEO. Optymalizacja grafiki Wyszukiwarki indeksują cały content blogu, w tym grafikę i biorą ich pod uwagę w tworzeniu wyników wyszukiwania. W żadnym wypadku nie należy ignorować optymalizacji obrazów. W edytorze grafiki WP pozwala dodać tytuł, alt, podpis i opis. Wykorzystajcie to! Podłączenie instrumentów analitycznych Analityka to nieodłączna część pozycjonowania. Bez badania danych będziecie działać tak naprawdę na ślepo, nie posiadając możliwości efektywnego kierowania kampanią reklamową. W sieci jest wiele narzędzi analitycznych, pozwalających zbierać informacje o ilości odwiedzających, ich zachowaniu na stronie, źródłach ruchu, frazach kluczowych, z których przechodzą użytkownicy na wasze serwisy, i innych niemniej ważnych czynnikach. Niewątpliwie najbardziej popularnym z nich jest Google Analitycs. Integracja z sieciami społecznościowymi Obecnie nie można przedocenić roli sygnałów socjalnych w sferze SEO. Wyszukiwarki biorą pod uwagę przeróżne formy aktywności Internautów w serwisach społecznościowych (udostępnienia, polubienia i inne), co wpływa na wyniki. Jeśli do tej pory nie ustanowiliście panelu socjalnego na waszym blogu, nie zwlekajcie. Oprócz pozytywnego wpływu na proces pozycjonowania, ten instrument zapewni wam również dodatkowy ruch. Sprawdzenie pracy blogu po aktualizacji schematów i wtyczek Nie zależnie od tego, że platforma WordPress jest względnie solidna i stabilna, mogą się jednak zdażyć chwilowe problemy w pracy pluginów i schematów. Obowiązkowo należy sprawdzić ich działanie po zainstalowaniu, czy nie powodują błędów i konfliktów. Czy ważne są tagi przypisane we właściwościach zdjęcia? Czy tam też umieszczać frazy kluczowe? Tak, lecz nie należy przesadzać ze słowami kluczowymi, przede wszystkim opis w atrybucie ALT i Title powienien dawać więcej informacji o grafice, i powienien być z nią powiązany. Należy także pamiętać o nazwie pliku graficznego, on też powinien oddawać sens grafiki. Pamiętajmy, że roboty nie rozpoznają grafiki i identyfikują ją przede wszystkim po nazwie pliku oraz opisach w alt i title. Czym dokładniej opisana grafika, tym lepiej i szybciej zostanie ona zaindeksowana i wyświetlana dla określonych zapytań.- 35 odpowiedzi

-

Cześć, nieco prywaty bo dawno tutaj nie zaglądałem ale mam coś bardzo ciekawego dla dropshipperów. Mianowicie https://descrb.com/ słowem wstępu video: Descrb na podstawie analizy zdjęcia jest w stanie rozpoznać produkt i wypisać jego najwazniejsze funkcjonalności + dobry opis z słowami kluczowymi. Uprzedzając pytania, nie to nie jest kolejny reskin GPT. GPT nie ogarnia marek, jest to własny podkręcony przetrenowany model z optyką na ecommerce. Jeżeli chodzi o funkcjonalności są to: (tutaj coop z chatem gpt) 🖼 Generuj opisy produktów na podstawie zdjęć w sekundach. (Wspomniane wyżej) 🌍 Wielojęzyczne opisy dostosowane do Twojego rynku. (Z racji tego że core zespołu jest z Polski, opisy pod PL są dostosowane stosunkowo dobrze, najlepiej działa pod angielski ale co do polszczyzny to nie ma wstydu). 🧠 Inteligentna integracja słów kluczowych dla lepszej widoczności SEO. (Dodajesz słowo kluczowe "pizza" descrb dodaje jest do opisu w dobrym kontekście). 📜 Odkrywaj historie marek i produktów, by bardziej angażować swoich klientów. (Np. Historia brandu adidas, hugo boss) 🔍 Zrozum technologie i materiały, z których wykonane są produkty. (Np. Guma jako materiał, uultraboost jako technologia itd) Dodatkowo, mamy api, potencjalne integracje z PIM systemami, dla każdego coś fajnego. 50 opisów za darmo, jednak po wyczerpaniu limitu puście mi sygnał po starej znajomości coś załatwie PS. Załączam opis

- 6 odpowiedzi

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

Zbiór darmowych narzędzi A.I https://h-supertools.com/ Writery.Seo a nawet przesyłanie plików do 10 G

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

Od jakiegoś czasu zajmuję się sklepem "Print On Demand" -> Redbubble + Teepublic. Jakieś sprzedaże wpadły..... czyt. grosze 😕 a najlepsze w tym wszystkim jest to, że na ponad 1k prac graficznych mam ponad 3.3k polubień -> jeden z użytkowników tego forum(którego wszyscy znacie) stwierdził, że to niemożliwie :D. Co do sprzedaży, to fajnie by było gdyby wpadało trochę więcej..... Próbowałem już reklamować produkty na facebook-u(teraz zastanawiam się nad założeniem strony sklepu), Pinterest, Instagram ale skutek jest mizerny. Proszę o jakieś porady jak zwiększyć ruch na stronie -> do niedawna pozycjonowanie robił mi użytkownik Kumitssu i ruch był duży ale niestety już się tym nie zajmuje.

- 2 odpowiedzi

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

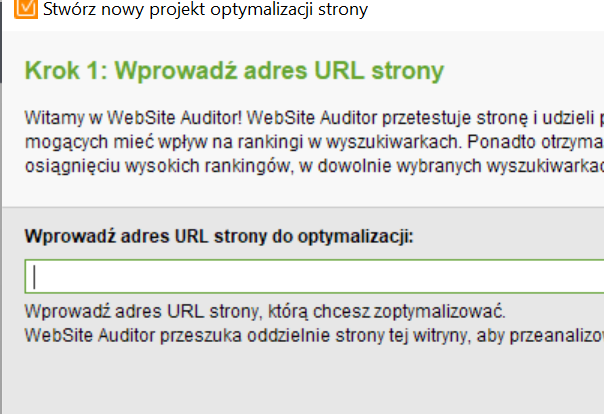

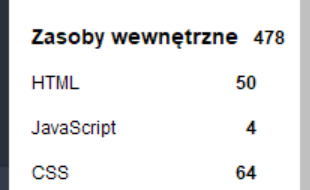

Program o którym będę dzisiaj mówił to WebSite Auditor Jest to program do pobrania na komputery, prócz website auditor dostajemy także 3 inne narzędzia, ale dzisiaj nie będę się na nich skupiał. Czym jest WebSite Auditor? To program w którym wykonamy audyt treści / audyt techniczny / sprawdzimy co musimy zrobić, że nasza strona była lepsza niż strony konkurencji. Od czego zacząć? Na początek włączmy program i tworzymy nowy projekt. Zdecydowanie na początku polecam wprowadzić nazwę naszej strony i sprawdzić co możemy na niej zoptymalizować. 1. Audyt Witryny - Zróbmy szybki audyt naszej witryny i wyeliminujmy błędy związanie z przekierowaniami / linkiami / indeksowaniem itd. (wszystko jest rozpisane w programie, dlatego nie będę po kolei tłumaczył co zrobić) 2. Wizualizacja - tutaj sprawdzisz ile łącznie masz stron i jaka jest ich głębokość kliknięć (najlepiej, żeby było 1 to oznacza, ze jednym kliknięciem możemy przenieś się na dowolną stronę) 3. Strony - Tutaj sprawdzisz liczbę stron na danych podstronach / linki / linki dofollow / obrazy z alt tagami / Przeskanuje wszystkie linki afiliacyjne na twojej stronie, pamiętaj, żeby ustawić je na nofollow (google ich nie lubi ) 4. Wszystkie zasoby - tutaj mamy techniczne rzeczy jak HTML / JS / CSS (dla zaawansowanych) Okej, ale weźmy się teraz za dokładne przeanalizowanie podstron, możesz robić to tylko na swojej stronie, ale także analizować np. TOP 5 stron pod twoich słowem kluczowym Wchodzimy w Audyt Strony -> Audyt Techniczny -> wklej link do swojej podstrony i dodaj słowa kluczowe pod które się pozycjonujemy (polecam wpisać ich co najmniej 5 bardzo podobnych słów kluczowych) Audyt pokaże nam co jest do poprawy i napisze jak naprawić ten błąd. Po przejściu niżej będzie mieli także gotowy Audyt Treści, który jest tutaj najistotniejszym elementem. Pokaże nam ile posiadamy słów kluczowych w nagłówkach, w sekcji body, czy słowa alt się nie powielają itp. Jak zrobić to lepiej niż konkurencja? Wpisz słowo kluczowe w google -> wybierz 5 najwyżej pozycjonowanych podstron -> wrzuć je do programu i zobacz co mają lepiej od twojej strony - Sprawdź ilość słów kluczowych w nagłówkach - Sprawdź ilość słów kluczowych sekcji body - Sprawdź łączną ilość słów na stronie (być może u ciebie jest ich za mało) - Sprawdź czy nie masz za dużo słów kluczowych (google nie lubi upychania) Warto sprawdzić też opcje TF-IDF (pokaże ci które ze słów kluczowych powinieneś dodać, a ile odjąć) Raport i Przegląd Domeny To bardzo fajna opcja, która pokaże ci ilość linków dofollow i nofollow na twoją stronę. Jaka jest siła domeny, według różnych czynników. Pokaże podsumowanie strony i wyświetli łączną ilość błędów. Opcji jest bardzo dużo, trzeba tylko trochę zgłębić jak działa program, sam przyznaje, że korzystam od kilku dni, ale bardzo ułatwia mi to analizę konkurencji (jak długie pisać artykuły, ile słów kluczowych zawierać itd.) Najlepiej jak z tych TOP 3-5 stron zrobimy to tak jak oni i coś ponad to, na pewno pomoże to w pozycjonowaniu. Jeśli twoja strona ma artykuł z 1000 słów i jest na 15 pozycji, a strona konkurencji ma 4000 słów i jest na 3 to wiemy na czym się skupić. Narzędzie jest oczywiście bezpłatne https://www.link-assistant.com/website-auditor/ Jeśli poradnik ci się spodoba zostaw proszę punkt reputacji, dzięki

- 1 odpowiedź

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

Witam! Mój poziom wiedzy o seo równy jest zero. Od czego najlepiej zacząć? Polecie jakiś youtuberów, blogi, kurs? Pozdrawiam

- 5 odpowiedzi

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

Witajcie! Nie znalazłem tutaj niczego takiego podobnego. Wiem, że większość z Was lata na grach, hackach i się możecie wkurzać jak dostaniecie zgłoszenie DMCA i pyk, nie ma Was we wszechwiedzącym Gógle. Co robić? Panika? Strach? Nie ma jak zapłacić za prąd? Już chcesz uciekać do Syrii, ale kiedy widzisz ten temat...zostajesz w Polsce. Pewnie ani ja tego nie odkryłem, ani ja tego pierwszy nie stestowałem, ale mam dla Was poradnik jak sobie pomóc kiedy dopadnie Was wyżej wymieniony przykład. Poradnik jest..krótki, po prostu. Start poradnika Skopiuj swój cały post gdzie dostałeś zgłoszenie DMCA. Ładnie cały, można też duplicować przy użyciu wtyczki. Usuń post gdzie dostałeś zgłoszenie DMCA. Całkowicie, a nie, że będziesz go odpubliczniać (rajza słowotwórca). Po usunięciu wrzuć link, który prowadził do niego do google submit. Stwórz nowy post (normalnie na tej samej domenie) wklejając treść jak leci, którą wcześniej skopiowałeś. Zmień title np coś do niego dopisując, to samo tyczy się URLa. Wrzuć potem link do google submit. Upublicznij post. Wejdź na direct admin swojego hostingu i ze starego postu zrób przekierowanie 301 na ten nowy post. Kup sobie gazetę, nawet kilka gazet. Czekaj. U mnie trwało to dokładnie 3 dni. Efekt końcowy Podsumowanie: Google jest głupsze niż niektórzy z Was myślą PS. U mnie wyszło, to był mój pierwszy DMCA od x czasu. Nie wiem czy u Was zadziała, ale może lepiej przetestować? Koniec poradnika #EDIT Wszystkie kw wróciły na swoje miejsce po DMCA, ten trzeci to huśtawka

- 14 odpowiedzi

-

- co robić jak dmca

- poradnik seo

-

(i 2 więcej)

Oznaczone tagami:

-

11 narzędzi do generowania tekstów oraz gdzie zamawiać teksty

Wujek Ziemny opublikował(a) temat w Case Study i Poradniki SEO

Nie od dziś mówi się, że “content is king”. Wraz z coraz to nowymi zmianami w algorytmie Google, jakość i ilość treści zamieszczanej na stronie staje się kluczowym czynnikiem mającym wpływ na pozycje w wynikach wyszukiwania. Jeśli prowadzisz własną stronę, wiesz, że pisanie artykułów nie zawsze jest przyjemne, a praktycznie zawsze zajmuje mnóstwo czasu. W tym artykule znajdziesz listę narzędzi, które pozwolą Ci ograniczyć czas pisania artykułów do minimum. Niektóre z nich dosłownie napiszą te artykuły za Ciebie! Serwisy do generowania treści Serwisy te generują artykuły, które mogą być punktem wyjścia do napisania artykułu docelowego. Ich jakość nie jest zła, ale nie jest też powalająca. W niektórych przypadkach mogą zdarzyć się plagiaty. Ideą takich narzędzi jest składanie dużej ilości artykułów znalezionych w sieci w jedną całość. Serwisy te są stosunkowo tanie i łatwe w użyciu. SEO Content Machine Wśród funkcji programu SEO Content Machine znajdziemy między innymi: Tłumaczenie tekstów na inne języki Kreator treści na Tier 1 Harvest zdjęć i filmów do artykułów Możliwość dodawania własnych zdjęć i filmów Tworzenie Bio Integrację Copyscape Integrację z całą masą spinnerów Postowanie bezpośrednio na Wordpress Program harvestuje teksty znalezione w wyszukiwarce pod wpisanym przez nas słowem kluczowym, następnie łączy je w całość i daje nam gotowy artykuł. Artykuł ten możemy wyeksportować w formie czystego txt, HTML oraz do formatów konkretnych programów, jak np. RankerX lub GSA SER. Źródłem artykułów mogą być wyszukiwarki, pliki lokalne lub Article Builder i Big Content Search (opcje płatne). W tekście możemy zamieszczać nasze linki z poziomu kreatora artykułów. Wystarczy wpisać nasze URLe, wybrać słowa kluczowe, ustawić częstotliwość oraz format i gotowe. Autorzy SCM oferują darmowy TRIAL na 5 dni Sprawdź SeoContentMachine Article Builder Article Builder od SCM różni się sposobem zdobywania tekstów bazowych. Ma on gotową bazę artykułów na różne tematy, np. refluks, starzenie się, cukrzyca, ubezpieczenia itp. Sprawdza się on przy popularnych niszach, które nie wymagają dokładnego researchu przy tworzeniu treści. Dodatkowo, artykuły generowane przez Article Builder są mocno zespinowane, więc ich czytelność oraz unikalność mogą pozostawiać wiele do życzenia. Niektóre z funkcji Article Builder: Postowanie bezpośrednio na stronę internetową przez API Bardzo obszerna baza artykułów źródłowych Teksty są od razu zespinowane Serwis jest bardzo prosty w użyciu Jeśli chcesz wypróbować Article Builder, możesz zrobić to w SeoTools! Article Forge Article Forge powstał w 2015 roku, a za jego sukcesem stoi ta sama firma, która stworzyła WordAI. Jest serwisem, który zna chyba każdy, kto kiedykolwiek zapoznał się z tematem automatyzacji pisania treści. Niektóre z zalet Article Forge: Integracja z niektórymi aplikacjiami, np. SEO Autopilot, WordAI, GSA SER, RankerX Serwis używa AI do tworzenia tekstów Możliwość dodawania zdjęć i filmów Możliwość masowego tworzenia artykułów Article Forge 3.0 pozwala na tworzenie tekstów w następujących językach: angielski, holenderski, hiszpański, włoski, francuski, portugalski, niemiecki. Autorzy serwisu twierdzą, że artykuł napisane przez Article Forge doskonale imituje tekst napisany przez człowieka. Z doświadczenia mogę powiedzieć, że jest to prawda w przypadku popularnych nisz, jednakże przy nieco mniej popularnych tematach serwis może napisać nam tekst o czymś zupełnie innym. Article Forge oferuje 5 dni DARMOWEGO triala Sprawdź Article Forge - darmowy trial Programy AI - sztuczna inteligencja Od jakiegoś czasu bardzo popularne stały się serwisy korzystające z modelu GPT-3 do pisania artykułów. Wydają się one dużo lepszą alternatywą dla dawnych generatorów treści, ponieważ dużo trafniej opisują to, co chcemy, by opisały. Wygląda na to, że AI jest kolejnym krokiem do rewolucji technologicznej. Pozwala to nam zaoszczędzić mnóstwo czasu. Poświęcając kilka minut uzyskamy bardzo wysokiej jakości. Jarvis.AI Na temat Jarvis.AI pisałem już tutaj, dlatego pozwolę sobie skrócić jego opis do przystępnego minimum. Jarvis to serwis oferujący pisanie tekstów za pomocą sztucznej inteligencji. Pozwala on pisać nie tylko wpisy na blogi, ale również, między innymi: nagłówki Google Ads i Facebook Ads e-maile sprzedażowe treści SEO teksty marketingowe Serwis posiada ponad 50 różnych szablonów, więc jest w czym wybierać. Wystarczy wpisać kilka podstawowych informacji, jak słowo kluczowe, krótki opis, określić ton, w jakim tekst ma być napisany i gotowe. Ponadto, Jarvis potrafi pisać w ponad 25 językach, w tym po polsku. Istnieje też możliwość podawania danych w jednym języku i tworzenia artykułu w innym języku. Możesz skorzystać z darmowego TRIALA tutaj Darmowy trial Jarvis Rytr Rytr to konkurencja dla Jarvis.ai. Zasada jego działania jest praktycznie ta sama, co poprzednika. Rytr korzysta z AI do pisania artykułów, nagłówków, treści reklamowych i innych tekstów. Wystarczy wybrać jeden z ponad 30-tu szablonów, jeden z ponad 30-tu języków i jeden z ponad 20-tu tonów, by stworzyć doskonały tekst. Niektóre z funkcji Rytr: Analiza tekstu pod kątem SEO dla znalezienia optymalnych słów kluczowych Aplikacja działa na urządzeniach mobilnych Rytr posiada wtyczki do Wordpress, Shopify i innych platform Możliwość integracji poprzez API Zarówno Rytr, jak i Jarvis mają swoich zwolenników, dlatego ciężko jest określić który z nich jest lepszy. Sprawdź Rytr Spinnery - synonimizatory tekstu Spinnery pozwalają na zwiększenie unikalności artykułów. Służą one do synonimizacji tekstu - zamieniają konkretne słowa na ich odpowiedniki przy zachowaniu sensu zdania. Wraz z rozwojem technologii, spinnery zaczęły wykorzystywać nowe metody synonimizacji. W chwili obecnej najlepsze synonimizatory potrafią nie tylko zamieniać słowa, ale też przepisywać na nowo całe zdania, zmieniając ich szyk oraz przepisywać całe paragrafy lub dodawać nowe treści. Wszystko to po to, by uniknąć plagiatu. The Best Spinner Jest to chyba najstarszy spinner z listy. Karierę rozpoczynał jako aplikacja desktopowa, ale wraz z kolejnymi wersjami autorzy przeszli na aplikację webową. TBS potrafi spinować słowa, zdania, a nawet całe paragrafy. Obsługuje 14 języków. Wśród konkurencji wyróżnia się funkcją eksportu zespinowanego artykuły do MP3, dzięki technologii Text-To-Speech. WordAI Mocno rozpoznawalny gracz na rynku spinnerów. Za jego powstanie odpowiadają twórcy Article Forge. Posiada te same opcje, co The Best Spinner (poza eksportem do MP3), a od konkurentów odróżniają go następujące funkcje: rozumienie znaczenia słów w zależności od kontekstu rozumienie w jaki sposób poszczególne słowa wchodzą w interakcję z innymi słowami pisanie tytułów wzbogacanie tekstu WordAI - darmowy 3 dniowy trial SpinRewriter SpinRewriter to konkurencja dla WordAI. Również rozumie znaczenie słów oraz interakcje pomiędzy wyrazami. Potrafi zmieniać tryb zdań z pasywnego na aktywny i z aktywnego na pasywny. Nie różni się zbytnio od swojej konkurencji, jednak posiada on funkcję integracji z Copyscape, której nie posiada WordAI. Jego minusem, względem WordAI, jest brak możliwości spinowania tytułów oraz brak obsługi języków innych, niż angielski. Wszystkie trzy serwisy możesz wypróbować za ułamek ich ceny dzięki SeoTools! Serwisy do zamawiania treści Jeśli preferujesz całkowicie oddelegować wszystkie czynności związane z pisaniem artykułów, najlepszym wyjściem będzie skorzystanie z serwisów oferujących usługi copywritingowe. Poniżej znajdziesz 3 wybrane przez nas serwisy, zarówno rodzime, jak i zagraniczne. TextBookers Serwis powstał w Polsce w 2013 roku i działa do dziś. Dzięki niemu możesz zlecić napisanie wszelkiego rodzaju treści, od tekstów preclowych i zapleczowych, aż po specjalistyczne artykuły. Ceny różnią się w zależności od rodzaju tekstu, który chcesz zlecić. Przykładowo: Tekst zapleczowy kosztuje 6.27zł brutto za 1000 znaków Tekst specjalistyczny kosztuje 21.92zł brutto za 1000 znaków Za każde doładowanie konta w serwisie otrzymujemy darmowe punkty do wykorzystania na kolejne zlecenia. Sprawdź TextBookers GoodContent GoodContent to drugi rodzimy serwis oferujący usługi copywritingowe. Portal chwali się najszybszą realizacją zleceń na rynku dzięki współpracy z ponad 20 000 copywriterów. Ciekawą opcją jest możliwość określenia własnej stawki w zależności od swoich wymagań. Serwis określa jedynie minimalny próg. Sprawdź GoodContent Fiverr Fiverr to globalna platforma dla freelancerów. Każdy może wystawić tam swój “gig”, czyli ofertę, dlatego nie powinien dziwić nas fakt, że znajdą się tam też copywriterzy. Niegdyś serwis słynął z tego, że kwota, za którą wykonywany był gig wynosiła $5. Aktualnie platforma zrezygnowała z tego trendu i możemy tam spotkać ogłoszenia w każdej cenie. Ważne jest, by podczas wyszukiwania copywritera dokładnie zapoznać się z opiniami na jego temat oraz szczegółami oferty. Choć jesteśmy chronieni przez Fiverr przed wyłudzaczami, to jednak szkoda czasu na zlecanie pracy komuś niesprawdzonemu. Sprawdź Fiverr- 6 odpowiedzi

-

- seo

- poradnik seo

- (i 8 więcej)

-

Crowd Links to linki zamieszczane w witrynach z recenzjami, mediach społecznościowych i innych blogach, na których komentarze czytelników działają jako rekomendacje, recenzje, opinie i rekomendacje produktów. Zazwyczaj linki te są tam umieszczane, aby zwiększyć świadomość marki , stworzyć pozytywną opinię o produkcie lub usłudze marki oraz zwiększyć ruch na stronie. Strategiczne rozmieszczenie linków Crowd Links to świetny sposób na osiągnięcie celów marketingowych i SEO. Nazywa się to reklamą organiczną i jest najlepszą metodą, aby Twoja marka lub firma stała się autorytetem niszowym. Ale jedna rzecz musi być na miejscu: świetne treści z przydatnymi informacjami. Gwarantuje to, że odwiedzający nie tylko zostaną, ale także będą odsyłać innych z powrotem do Twojej witryny. Jak działają Crowd Links Marketing społecznościowy stał się niezwykle pomocną strategią budowania pozycji SEO (dzięki nowym algorytmom wyszukiwarek takich jak Google) w lidze firm internetowych. Zasadniczo każda firma, która chce zwiększyć swoje wskaźniki SEO, będzie musiała uwzględnić linki tłumu w swojej strategii marketingowej. Crowd Links z serwisów z pytaniami i odpowiedziami, forów internetowych i sieci społecznościowych, takich jak Quora, Reddit i media społecznościowe, znacznie poprawiają dziś pozycję witryny w wyszukiwarkach. Pomimo tego, że te linki są no-follow, nadal są bardzo cenne dla Twojej witryny. Ten rozwój jest spowodowany tym, że najnowsze algorytmy wyszukiwarek kładą nacisk na linki tłumu jako obowiązkowy element budowania wysokiej jakości masy linków na stronie internetowej. W szczególności wyszukiwarki są zaprojektowane tak, aby traktować te linki jako naturalne, ponieważ zostały tam umieszczone przez osoby, które rzekomo miały bezpośredni kontakt z Twoją marką. Dodatkową korzyścią są Crowd Links, które dodatkowo ułatwiają i poprawiają komunikację na żywo między Twoją marką a grupą docelową. Za pomocą crowdlinków możesz osiągnąć następujące cele: Zwiększanie świadomości marki : dopóki marketing społecznościowy odbywa się w sposób naturalny, pomaga on budować świadomość marki w odniesieniu do nowych produktów lub usług, zwłaszcza jeśli masz niski budżet na promocję. Zwiększenie ruchu : następuje to bezpośrednio, gdy otrzymujesz ruch polecający z innych platform. Poza tym im więcej masz linków zwrotnych, tym wyższą pozycję w rankingu zajmuje Twoja witryna, więc więcej osób kliknie na Twoją witrynę. Pozyskiwanie potencjalnych klientów : jeśli strategicznie kierujesz do swoich idealnych odbiorców wysokiej jakości treści na odpowiednich platformach, będą oni odwiedzać Twoją witrynę w poszukiwaniu rozwiązania swojego problemu. Dlatego marketing społecznościowy może być wykorzystywany do generowania leadów. Budowanie autorytetu : Kolejną korzyścią marketingu społecznościowego jest możliwość ustanowienia marki jako autorytetu niszowego i lidera myśli. Zwiększaj zaangażowanie : możesz zaangażować swoich docelowych odbiorców i skłonić ich do podjęcia działań. Korzyści z Crowd Links Poniżej przedstawiamy korzyści płynące z używania linków społecznościowych w ramach strategii SEO. Możesz na stałe umieścić swoje linki w wielu witrynach. Dzięki takiemu podejściu nie musisz regularnie kupować ani wypożyczać nowych linków. Musisz jednak uważać, aby nie umieszczać swoich linków w dowolnym miejscu, aby uniknąć sankcjonowania przez wyszukiwarki. To doskonały sposób na umieszczenie różnych rodzajów linków w swoim profilu linków: wykonaj obserwowanie, nie śledź, tekst, przekierowanie, niezakotwiczone itp. Crowd links umożliwiają poprawę rankingu linków Twojej witryny poprzez ich naturalną integrację. W ten sposób unikniesz ryzyka odfiltrowania. Jak wspomniano wcześniej, linki tłumu umożliwiają generowanie wysokiej jakości ruchu polecającego od docelowych odbiorców. W przeciwieństwie do ogólnego marketingu w mediach społecznościowych, gdzie większość osób, które widzą Twoją reklamę, może nie być zainteresowana, istnieje większe prawdopodobieństwo, że uzyskasz więcej konwersji z marketingu społecznościowego. Pułapki Crowd Links Następujące wady marketingu społecznościowego można uznać za: To długa gra. Nie zobaczysz od razu znaczącego wzrostu ruchu. Rezultaty mogą pojawić się po kilku miesiącach aktywnej pracy. Nie przestawaj próbować! Marketing społecznościowy to bardzo czasochłonny proces. Być może będziesz musiał skorzystać z usług agencji marketingu społecznościowego, aby stworzyć i opublikować dużą liczbę komentarzy i recenzji lub spędzić godziny w swoim własnym czasie. Co należy zrobić podczas umieszczania linków do tłumu Te wytyczne pomogą Ci uniknąć pułapek marketingu społecznościowego, zwłaszcza przy podejmowaniu decyzji, na których platformach umieścić swoje linki. Postępuj zgodnie z tymi zasadami, aby odnieść sukces: Temat dyskusji powinien odpowiadać promowanemu produktowi lub usłudze. Opublikuj swoje linki tylko w odpowiednich tematach lub forach, na których Twój produkt jest związany z dyskusją. Kampanie promocyjne najlepiej przeprowadzać w witrynach, w których Twoi docelowi odbiorcy spędzają najwięcej czasu. Publikuj w witrynach o dużym natężeniu ruchu. Zwiększa to liczbę możliwych do uzyskania kliknięć. Kieruj się tylko na aktywne dyskusje lub ostre tematy. Nie publikuj zbyt wielu linków na raz. Jeśli Twoja firma jest nowa i nagle Twój link staje się wirusowy, wyszukiwarki takie jak Google uznają, że jest nienaturalny i nie organiczny. Unikaj spamu. Najlepiej używać wysokiej jakości treści. Twórz rekomendacje tylko z zaufanymi kontami. Unikaj promowania swojego linku za pomocą komercyjnych kotwic, ponieważ nie wyglądają one naturalnie. Zaufani zwykli użytkownicy linkują do prostych słów kluczowych. Pamiętaj: aby rozwinąć kampanię crowdmarketingową, niezbędne jest ostrożne i strategiczne wykorzystanie linków społecznościowych.

- 3 odpowiedzi

-

- seo

- poradnik seo

-

(i 1 więcej)

Oznaczone tagami:

-

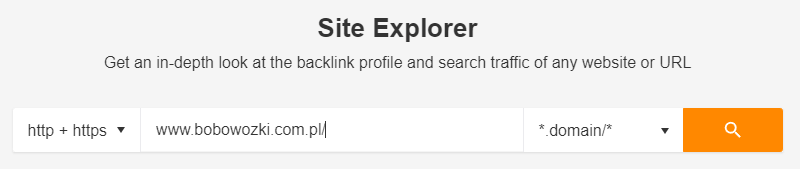

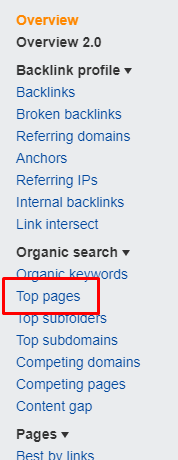

Jak zbadać słowa kluczowe konkurencji w pięciu krokach

Wujek Ziemny opublikował(a) temat w Case Study i Poradniki SEO

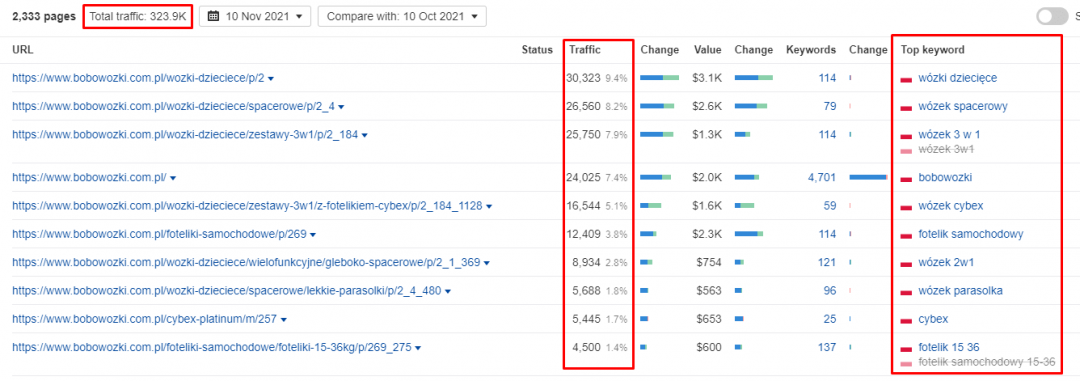

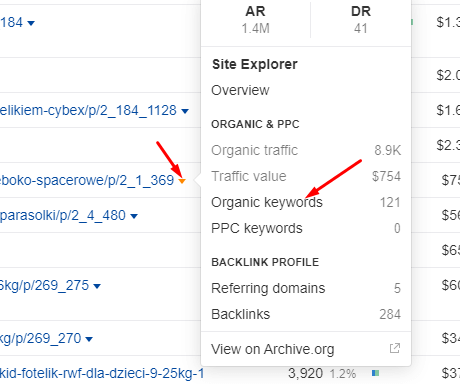

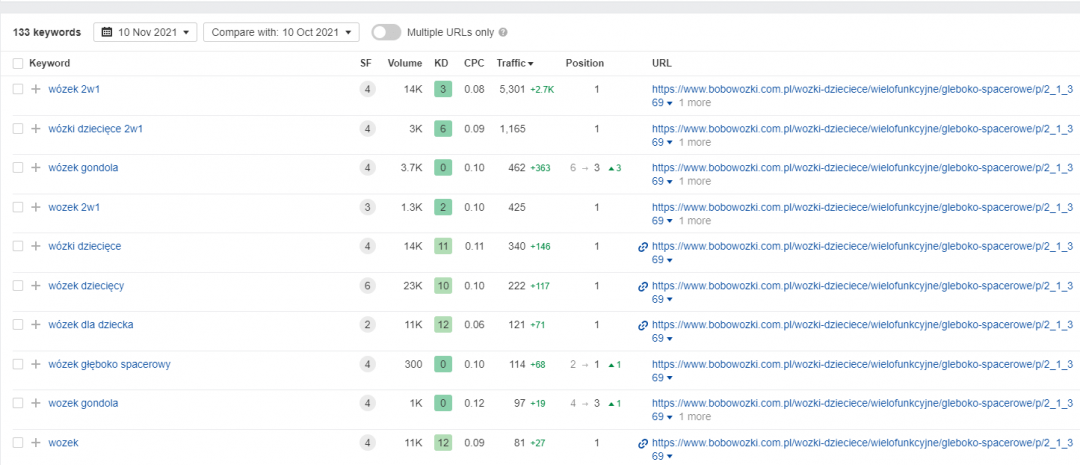

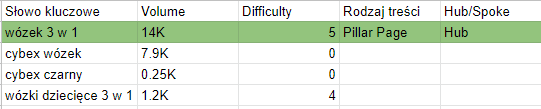

Po co skupiać się na konkurencji? Ponieważ Twoja konkurencja wykonała już całą ciężką pracę za Ciebie. A czym jest analiza słów kluczowych konkurencji (competitive keyword research analysis) i jak może Ci pomóc? CKRA to proces badania najbardziej wartościowych słów kluczowych na poziomie strony Twojego konkurenta, w celu określenia, na które keywordy powinieneś zwrócić uwagę. Skupiając się na swojej konkurencji, możesz uzbroić się w ogrom słów kluczowych i pomysłów na treści, które gwarantują wygenerowanie ruchu na stronie. Oto krótki przegląd tego procesu: Zrób listę swoich głównych i drugorzędnych konkurentów Wprowadź ich adresy URL do Site Explorer w Ahrefs Zidentyfikuj najlepsze słowo kluczowe, w które celuje każda strona Stwórz dokument dla głównej listy słów kluczowych Uporządkuj słowa kluczowe według hub, spoke i section (wytłumaczone w dalszej części artykułu) Celuj w najmniej trudne keywordy i powoli przechodź na cięższe A oto serwisy, których będziesz potrzebował, aby to osiągnąć: Ahrefs Google Sheets Zaczynajmy! Jak wykonać analizę słów kluczowych konkurencji w 30 minut lub krócej Zrób listę głównych konkurentów To, kogo wybierzesz jako swojego konkurenta, zadecyduje o sukcesie Twojej strategii badania słów kluczowych. Jeśli wybierzesz zbyt słabą konkurencję, możesz nie zobaczyć żadnych wartościowych treści. Z drugiej strony, wybierając konkurenta, który obsługuje ogromną część rynku, na którym nie prowadzisz swoje działania, znacznie trudniej będzie znaleźć odpowiednie słowa kluczowe, które wygenerują targetowany ruch. W tym poradniku będziemy używać zestawu narzędzi SEO Ahrefs. Inne narzędzia SEO typu "wszystko w jednym", takie jak SEMRush również powinny się sprawdzić. Jeśli poszukujesz serwisów, które pomogą Ci w realizacji założeń z tego poradnika, sprawdź SeoTools! Wprowadź adres strony konkurenta do Site Explorer w Ahrefs Wprowadź jeden z URLi do Site Explorer: Przejdź do raportu z zakładki Top Pages (lewa strona Site Explorer’a) W tym miejscu zostanie Ci przedstawiona lista najlepiej działających stron w witrynie Twojego konkurenta. Są to, w skrócie, strony, które generują najwięcej ruchu. Oto kilka ważnych rzeczy, na które warto zwrócić uwagę: Ruch całkowity: Jest to szacowany całkowity ruch, jaki ta witryna uzyskuje miesięcznie z ruchu organicznego. Jest on obliczany poprzez sprawdzenie pozycji każdej podstrony w rankingu wyszukiwarki na wszystkie słowa kluczowe. Najczęściej jest on niedoszacowany, a rzeczywista liczba jest 3-4 razy większa, Ruch na stronie: Podobnie jak powyżej, jest to szacowany ruch generowany przez daną stronę z wyszukiwarek w każdym miesiącu, Top Keyword: Jest to słowo kluczowe, które generuje największy ruch na stronie lub podstronie. Uwaga: najlepsze słowo kluczowe NIE jest koniecznie najlepszym słowem kluczowym, w które powinieneś celować. To po prostu słowo kluczowe, które generuje największy ruch na danej stronie. Na sam koniec kliknij w menu rozwijane i otwórz raport Organic Keywords dla każdej podstrony w nowej karcie. Otrzymasz listę wszystkich słów kluczowych, na których dana podstrona zbiera ruch: Zidentyfikuj najlepsze słowa kluczowe, na których chciałbyś się wybić Twoim celem jest wybranie najlepszego słowa kluczowego, na które chciałbyś się wypozycjonować. To, co decyduje o tym, czy dane słowo kluczowe jest "najlepsze" dla Twojego biznesu, zależy od Ciebie. Ja jednak zadaję sobie następujące pytania: Czy mój rynek docelowy jest zainteresowany dowiedzeniem się więcej na ten temat? Czy to słowo kluczowe ma wartość komercyjną? Czy moi konkurenci aktywnie starają się na nie pozycjonować? Czy możemy dopasować się do intencji użytkownika stojących za tym wyszukiwaniem? Jeśli możesz odpowiedzieć "tak" na co najmniej 3 z tych pytań, to prawdopodobnie jest to dobre słowo kluczowe, które warto targetować. Oto przykład: Jednym z naszych celów w tym roku jest zbudowanie programu partnerskiego, który łączy firmy z dostawcami usług marketingowych. Podczas badania Ahrefs.com i Quicksprout.com odkryliśmy, że słowa kluczowe takie jak "jak zdobyć klientów seo" i "pytania do firmy SEO" kierują pokaźne ilości ruchu na te strony każdego miesiąca. Czy mój rynek docelowy jest zainteresowany dowiedzeniem się więcej na ten temat? Tak! Dostawcy usług SEO zawsze szukają sprytnych sposobów na zdobycie większej liczby klientów. Firmy muszą mieć również przygotowaną listę pytań do SEOwców, aby zrozumieć pełen zakres tego, w co się angażują. Czy te słowa kluczowe mają wartość komercyjną? Tak. Pisząc na te tematy, moglibyśmy kwalifikować potencjalnych klientów, którzy przychodzą z wyszukiwarek i zbierać o nich informacje. Następnie, moglibyśmy dopasować je na podstawie zainteresowania i pobierać opłatę. Czy moi konkurenci aktywnie starają się pozycjonować na ten keyword? Tak. Zarówno Ahrefs jak i Quicksprout plasują się bardzo dobrze na tych słowach kluczowych. Czy możemy dopasować się do intencji użytkownika stojących za tym wyszukiwaniem? Tak. Jako dostawca usług marketingowych, mamy bezpośrednie doświadczenie w pozyskiwaniu klientów SEO dla siebie. Jak widzisz, te dwa słowa kluczowe przeszły nasz test bezbłędnie, więc dodaliśmy je do naszej listy i zaczęliśmy się na nie pozycjonować. Powtórz te kroki dla pozostałych topowych stron Twojego konkurenta Gdy Twoje słowa kluczowe przejdą test, dodaj je do dokumentu z główną listą słów kluczowych. Następnie powtórz ten proces. Kontynuuj przechodzenie przez strony konkurentów jedna po drugiej, aż będziesz miał co najmniej 50 słów kluczowych, które warto wziąć na celownik. Utwórz podstrony dla tych słów kluczowych, a następnie znajdź 50 więcej słów kluczowych. Rób tak w kółko. Następnie należy posortować keywordy. Uporządkuj swoje pomysły na słowa kluczowe Sukces Twojej strategii SEO zależy od wielu czynników. Ale są dwa obszary, z którymi firmy zmagają się cały czas. Brak możliwości znalezienia dobrych słów kluczowych Utrzymywanie uporządkowanej listy słów kluczowych Posiadanie nieuporządkowanej listy słów kluczowych wprowadza nieład i przyczynia się do występowania błędów. Przez to nie masz jasno określonej strategii, która powie Ci od czego zacząć i na czym się skupić. Rozwiążmy to, sortując słowa kluczowe w hub (piastę) i spokes (szprychy). Wyobraź sobie koło od roweru, w którego centrum jest piasta, a od niej odchodzą szprychy. Jeśli jesteś zaznajomiony z tym, jak działają wyszukiwarki i jak wyglądają ich preferencje dotyczące rankowania stron w oparciu o tematyczność, to będzie to dla Ciebie dosyć proste. Pomyśl o hubach jak o stronach filarowych. Są to strony, które działają jako główny filar dla wszystkich treści z nim związanych. Spokes, to pojedyncze strony, które są ściśle związane z szerszym tematem. Organizując swoje słowa kluczowe w ten sposób, będziesz miał wgląd w to, nad czym musisz popracować. Będziesz mógł dokładnie opisać temat, a nie tylko posiadać zestaw pojedynczych słów kluczowych. Celem SEO jest pokazanie wyszukiwarkom, jak istotne dla danego tematu są wszystkie twoje podstrony. Poprzez wewnętrzne powiązanie Twoich stron z Twoimi stronami filarowymi, Twój "wynik relewantności" wzrasta, co skutkuje wyższymi pozycjami w rankingu. Oto przykład tego, jak posortowaliśmy naszą listę słów kluczowych. Jak widać, próbujemy wypozycjonować się na słowo kluczowe: wózek 3 w 1. Ma ono 14,000 wyszukiwań miesięcznie, a jego trudność wynosi 5. Jest to nasz główny temat. Wszystkie okoliczne słowa kluczowe to różne treści związane z wózkami 3 w 1. Te artykuły lub landing page’e będą następnie wewnętrznie linkowane do naszej strony głównej “wózki 3 w 1”, tworząc silną relację między sobą. Zorganizowanie słów kluczowych w tematy i wewnętrzne powiązanie ich ze sobą prowadzi do wyższych pozycji w wynikach wyszukiwania i większego ruchu na stronie. Masz również rozpisane czarno na białym na czym powinieneś się skupić, więc możesz przejść do tworzenia treści. Targetuj najpierw proste słowa kluczowe Pamiętaj, że nie wszystkie słowa kluczowe są sobie równie. W przypadku niektórych z nich uzyskanie topowej pozycji w wynikach wyszukiwania jest kwestią kilku tygodni. W przypadku innych, bardziej skomplikowanych fraz, może Ci to zająć miesiące lub lata. Jednak nie cała nadzieja stracona. Aby przyspieszyć proces, możesz zrobić jedną z dwóch rzeczy: Zainwestować w jakiś super program do budowania linków (najczęściej jest to drogie i niezbyt bezpieczne) Skupić się najpierw na najłatwiejszych słowach kluczowych Pamiętasz wskaźnik trudności słowa kluczowego, który widziałeś podczas badania keywordów? Jest to ważne dla określenia, jak ciężko jest znaleźć się w pierwszej dziesiątce dla danego zapytania. Aby szybko się wybić, powinieneś wybierać te frazy, które mają najniższy wskaźnik keyword difficulty, a następnie przechodzić do coraz trudniejszych słów kluczowych. Artykuł przetłumaczony z GrowHackScale za przychody z reklam.-

- seo

- poradnik seo

- (i 5 więcej)

-

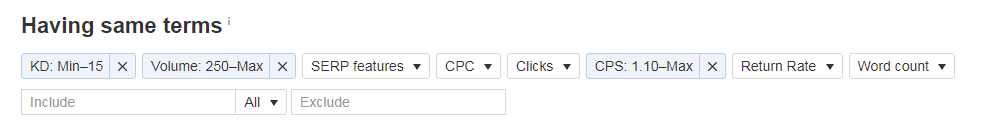

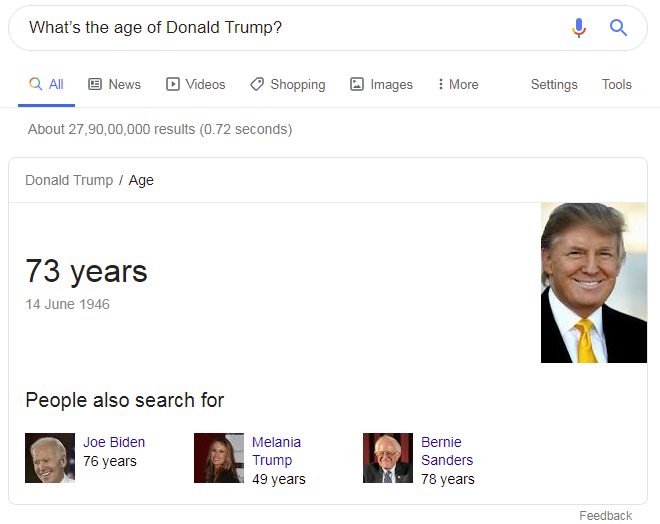

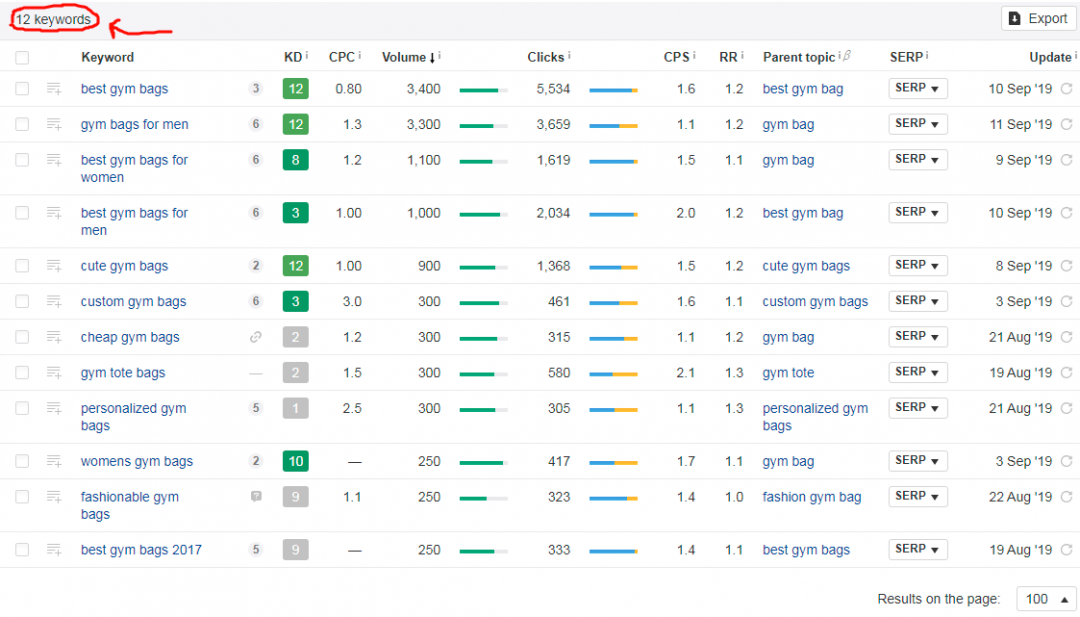

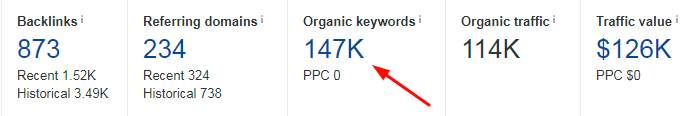

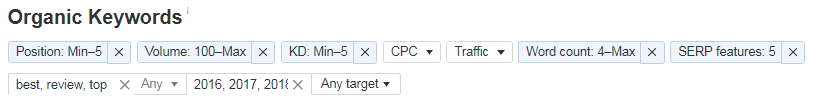

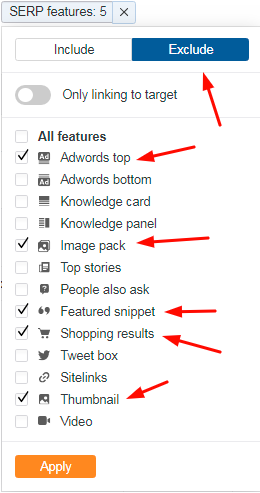

Chciałbym Wam dziś pokazać pewien sposób na wyszukiwanie łatwych słów kluczowych, które mogą Wam przynieść jakościowy ruch przy pomocy narzędzia jakim jest Ahrefs (dostępne jest w SeoTools). Poradnik ten jest przetłumaczony za środki z reklam na forum, więc dzięki że nas odwiedzasz! Użyjemy frazy "gym bags" jako naszej niszy (będziemy używać tej niszy w całym poradniku). Wyszukaj tą frazę w Ahrefs Keyword Explorer (główne menu) (Upewnij się, że masz zaznaczoną opcję USA jako target, możesz też dodać inne państwa) Teraz kliknij "view all" które znajduje się pod "having same terms". Po tym zobaczysz listę ok. 100 000 fraz (ahrefs w swojej bazie posiada bardzo dużo fraz) My nie potrzebujemy tych wszystkich fraz, przefiltruj je tak jak ja na screenie poniżej: KD: Minimum - 15 Ahrefs KD lub Keyword Difficulty (Trudność frazy) nie rozróżnia fraz kluczowych o niskiej konkurencji od tych z średnią konkurencją. Możesz spokojnie ustawić KD do 25. Volume: Maksymalnie - 250 Frazy z 250 wyszukań miesięcznie są świetne do targetowania. Powody: Większość witryn na pierwszej stronie wyników wyszukiwania nie targetuje na te frazy. Nawet jeżeli jakaś witryna targetuje w ten keyword to zazwyczaj zawiera mało treści Możemy wybić się na tą frazę targetując ten keyword i dodając wartościowy content CPS: Ilość kliknięć na wyszukanie = 1.1 To jest ważny czynnik, który jest zawsze pomijany przez marketerów którzy szukają dochodowych fraz. W uproszczeniu - jeżeli fraza posiada CPS więcej niż 1 to oznacza, że osoba która szuka danej frazy klika więcej niż jeden wynik wyszukiwania. Przykład: Jeżeli fraza to "What's the age of Donald Trump? to użytkownik otrzyma to: Jak widzisz, każdy kto wyszuką tą frazę otrzyma odpowiedź na swoje pytanie bez klikania jakiegokolwiek wyniku wyszukiwania. W tym przypadku CPS może wynosić nawet 0. Powiedzmy, że użytkownik wyszuka coś w rodzaju - "Why my dog is feeling sleepy?" W tym przypadku kliknie w jakiś wynik wyszukiwania po to aby otrzymać odpowiedź na zadane pytanie. Często zdarza się, że szukając informacji ludzie klikają więcej niż jeden wynik wyszukiwania. Mam nadzieję, że rozumiecie. Teraz wracamy do głównego tematu. Po tym jak ustawiłeś wszystkie filtry zostanie Ci mniej niż 100 fraz kluczowych (W zależności od Twojej niszy). Oto co otrzymałem ja (Używając frazy "gym bags"). Oto co będziemy robić: Sprawdzamy wyniki wyszukiwania dla każdej frazy klikając przycisk "SERP". Sprawdzamy czy jakaś słaba strona (DA mniejsze niż 20) pojawia się w rankingu między pierwszą a piątą stronę google. Wyszukujemy wszystkie frazy kluczowe tej strony po to żebyśmy my też mogli się na nie wybić. Zrozumcie, że backlinki są jednym z najważniejszych czynnik w SEO dlatego należy je dokładnie sprawdzić podczas analizowania fraz. Nasz ostateczny cel - Znaleźć słabe strony Teraz kliknij w każdy przycisk "SERP" aby sprawdzić czy jakaś słaba witryna rankuje na konkretną frazę czy nie. Dla pierwszej frazy "best gym bags" strona z DR równym 17 [domain raiting ahrefs'a 17, coś podobnego do DA] jest na 26 pozycji. To jest URL - https://garagegympower.com/best-gym-bags-for-women/ Otwórz "Site Explorer" w innym oknie i wyszukaj domenę [w tym przypadku będzie to garagegympower.com] Następnie kliknij w "Organic Keywords". Otrzymasz ostateczną listę fraz tej strony. Po kliknięciu zobaczysz ogromną listę fraz, teraz ustaw te filtry: Position: Min 5 Oznacza to, że chcemy otrzymać tylko frazy na które strona rankuje między pierwszą a piątą pozycją w google. Volume: Max - 100 KD: Min - 5 Word Count: Max - 4 [Skupiamy się na frazach "długiego ogona"] Include: best, review, top [Zaznacz any] Exclude: 2016,2017,2018 [śmiecowe longtaile, również zaznacz any] Zastosuj także ten filtr: Po zastosowaniu filtrów, kliknij przycisk export aby pobrać wszystkie frazy. Musimy jednak przeanalizować pobrane frazy aby zrozumieć cały proces. Przed analizą fraz, chciałbym żebyście wiedzieli że chcemy się skupić głównie na takich frazach: Frazy How-to, czyli keywordy typu "how to read faster". Stworzymy artykuł na 2000 słów tematycznie powiązany z frazą, dopracujemy stronę aby wyglądała zachęcająco. Te działania mogą sprowadzić na naszą stronę dużą ilość ruchu. "Best of" czyli frazy typu "Best running shoes for women". Frazy z literówkami [Zignoruj je] Więc, frazy które powinieneś wybrać zależą głównie od Twojej strony. Używając mixu fraz "how-to" i "best-of" sprawisz, że Twoja strona będzie bardziej różnorodna. Teraz skupię się na frazach typu "best-of". Weźmy tą frazę - "best running shoes for personeal tendonitis" Oto strony które zajmują wyniki na pierwszej stronie google: Zwróć uwagę, że: W top 10 jest 5 stron które mają DA mniejsze niż 19. Strony z pozycji 5# i 10# nie targetują tej frazy. Pojawiają się wysoko w wynikach tylko dzięki wysokiemu authority. [Te domeny ogólnie są bardzo mocne, dlatego google wrzuciło je w wyniki mimo tego, że nie targetują w ten konkretny keyword] Bierzemy się za tą frazę! Pewnie zapytasz o to, czy zabierze nam to dużo czasu? Rozwiązanie - To jest jedno z najlepszych rozwiązan na rynku SEO, tylko brzmi tak jakby zajmowało dużo czasu ale tak nie jest. Jeżeli wciąż się zastanawiasz to zatrudnij kogoś i wyślij mu ten poradnik żeby wiedział co ma robić. Podsumowanie: Dodaj swoją niszę do Ahrefs Keyword Explorer'a. Przefiltruj listę fraz i znajdź słabe strony które rankują na słowa kluczowe które zawierają w sobie zamiary użytkownika [aby mieć pewność, że użytkownik przeszuka wyniki wyszukiwania] Sprawdź dokładnie wszystkie frazy na które rankuje strona. Dodaj filtry o której pisałem wyżej a znajdziesz trochę dobrych fraz. Powtórz. Pamiętajcie, że jest to poradnik skierowany do początkujących. Za wszelkie komentarze z góry dzięki! Dostęp do tego narzędzia (i dziesiątek innych przy okazji) możecie uzyskać dzięki forumowej usłudze SeoTools. Jeżeli nie wiesz co to lub jak mogłaby Ci się przydać, napisz do mnie! Link do opisu usługi zostawiam poniżej.

-

- seotools

- poradnik seo

- (i 10 więcej)

-

Witam, widziałem jakiś czas temu ten poradnik, kiedy przygotował go MOZ. Był naprawdę dobrze napisany, zresztą co się dziwić, to nie pierwsi lepsi pozycjonerzy. Jedynym mankamentem było to, że był dostępny tylko w języku angielskim. Miałem się nawet podjąć próby tłumaczenia, ale okazało się, że ktoś to już zrobił za mnie (a dokładniej, sprawnymarketing.pl) Są tutaj zawarte wszystkie najważniejsze rzeczy, są one przede wszystkim aktualne i poradnik jest przeznaczony dla początkujących, ale polecam przeczytanie go każdemu! [PDF] Poradnik dla początkujących od MOZ'a [tłum. sprawnymarketing.pl]

-

Poradnik [SPRZEDAM] Poradnik SEO - "Promuj się jak Rajza, zarabiaj jak Rajza"

rajza opublikował(a) temat w Poradniki i nisze

1. Nazwa poradnika/niszy: Obszerny poradnik dotyczący SEO + dodatki (patrz spis treści) - "Promuj się jak Rajza, zarabiaj jak Rajza" 2. Opis poradnika/niszy: Zawarte są w nim MOJE OSOBISTE techniki, poradnik typu 'krok po kroku'. Dzięki niemu, nie będziesz musiał już się zastanawiać jak wbić się w TOPki Googla. Opisuje sposoby SEO na nisze francuskie oraz globalne. PS. Minimalne wydatki to praktycznie FCS + rzeczy go obsługujące. 3. Źródło pozyskania: własne 4. Zdjęcia/ dowody: SPIS TREŚCI PORADNIKA: 5. Kontakt: Zamówienia przyjmuję JEDYNIE pod mailem: zamowienie.rajza@gmail.com . Uwaga! Informacje dotyczące zamówień (adres paypal/numer konta) przesyłam w godzinach wieczornych oraz porannych do każdego kto zamówi oraz nie wyrażam zgody na żadne zrzutki. 6. Cena: PROMOCJA 250 złotych dla pierwszych dwóch osób, później cena wzrasta do 300 zł. W cenie zawarty jest 30 dniowy support dotyczący poradnika. Uwaga! Jeśli chodzi o dwie promocyjne sztuki to dostaną je pierwsi lepsi, którzy napiszą zamówienie - nie przyjmuję na nie rezerwacji! 7. Sposób zapłaty: Zaufani użytkownicy - PayPal, inni użytkownicy - przelew bankowy 8.Poradnik/nisze oddałem do recenzji: Zaufanym, recenzje pojawią się tutaj niebawem. (DaaV też otrzymał, ale jego recenzja pojawi się na dniach bo jutro ma egzaminy a balował 3 dni - sprawdzone info ) Recenzje (cdn): #EDIT Zapomniałem wspomnieć, że do poradnika dodaję listę do K2 oraz listy do GSA. Pozdrawiam!- 126 odpowiedzi

-

- seo

- poradnik rajza

-

(i 3 więcej)

Oznaczone tagami:

-

Poradnik Wszystko na temat zaplecza - poradnik od Seoway

Termik opublikował(a) temat w Rozmowy o SEO

Witam, Seoway.pl wypuścił ostatnio naprawdę dobry poradnik, a raczej kompendium wiedzy o tworzeniu zaplecza w SEO. Choć zaplecze kojarzy się z long tailem, to w tym krótszym i bardziej agresywnym SEO również może okazać się bardzo przydatne, chociażby w momencie, gdy robimy osobne strony na każdą niszę. Takie zaplecze pomoże w SEO każdej z tych stron. Wszystko na temat zaplecza - poradnik od Seoway- 8 odpowiedzi

-

- zaplecze poradnik

- zaplecze seo

-

(i 1 więcej)

Oznaczone tagami:

-