-

Polecana zawartość

-

Jak pisać treści na stronę internetową z wykorzystaniem AI

Wujek Ziemny opublikował(a) temat w Poradniki o SEO,

Tworzenie treści od podstaw może być procesem czasochłonnym. Istnieje wiele mniejszych kroków, o których należy pomyśleć w drodze do stworzenia atrakcyjnych treści, takich jak badanie rynku, SEO i redagowanie tekstu, a to tylko początek. Jednak nie musisz zaczynać od zera, gdy istnieją narzędzia AI, które mogą pomóc w tworzeniu wysokiej jakości treści.-

-

- 13 odpowiedzi

Wybrany przez

Ciamciaj, -

-

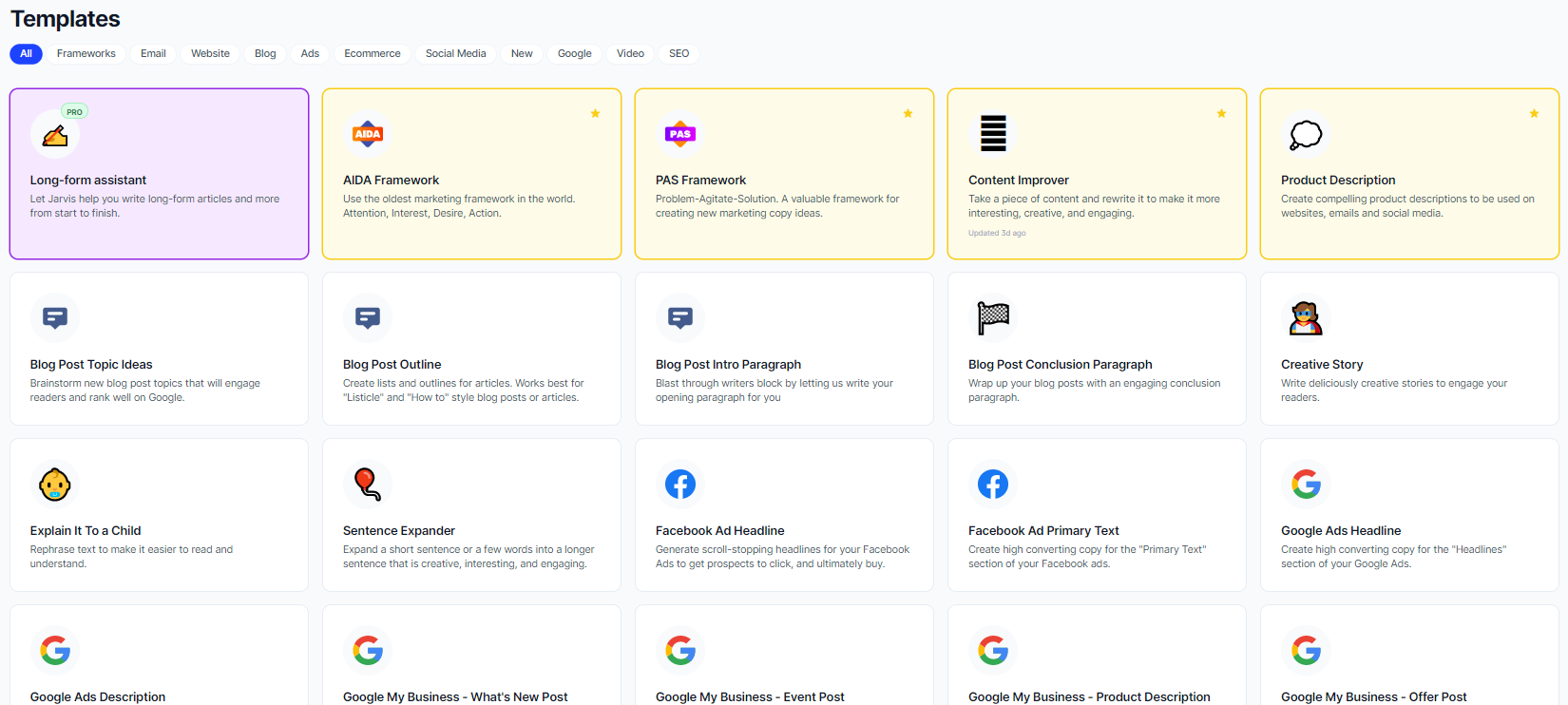

Jasper.AI (wcześniej Jarvis.ai) - Opinia -Serwis, który napisze za Ciebie wszystko

Wujek Ziemny opublikował(a) temat w White Hat,

Oprogramowanie oparte na sztucznej inteligencji analizuje wcześniejsze treści, aby stworzyć własny tekst, który jest podobny w tonie i stylu - bez plagiatu!-

-

- 24 odpowiedzi

Wybrany przez

Ciamciaj, -

-

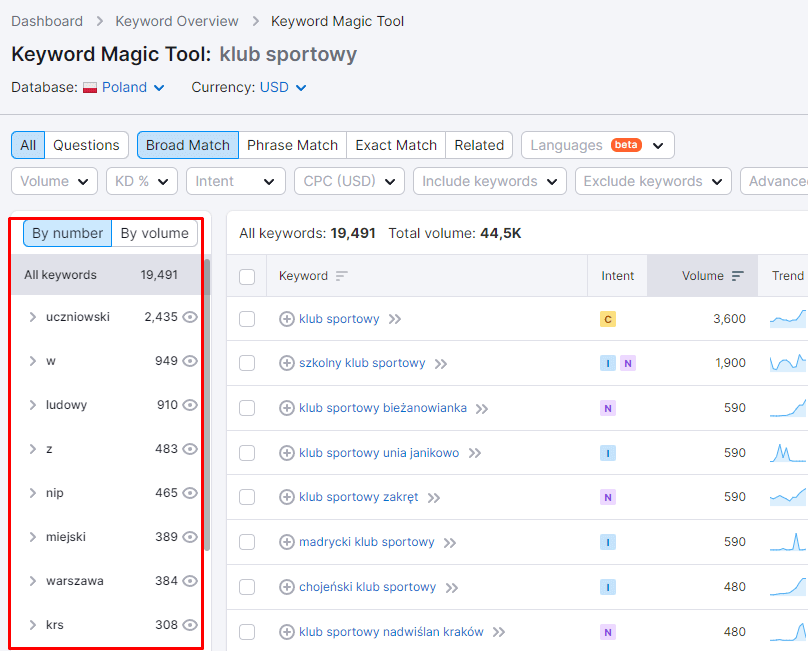

9 rzeczy, które możesz zrobić w SEMRush, by zwiększyć ruch swojej strony

Wujek Ziemny opublikował(a) temat w Poradniki o SEO,

Istnieje kilka sposobów, by wykorzystać SEMRush, aby zwiększyć swój ruch na stronie WWW i wspomóc swoją pracę w zakresie SEO i content marketingu.-

-

- 3 odpowiedzi

Wybrany przez

Ciamciaj, -

-

Jak zacząć zarabiać - przewodnik dla nowych EARNERÓW!

mysc opublikował(a) temat w Poradniki CPA,

Wszystko to co powinieneś wiedzieć, by realnie zarabiać w sieci! Podstawowe informacje na temat afiliacji i programów partnerskich, które pozwolą Ci poukładać wiedzę i zacząć zarabianie w Internecie.-

-

- 21 odpowiedzi

Wybrany przez

Ciamciaj, -

-

Lista 29 najlepszych darmowych narzędzi SEO (pozycjonowanie i optymalizacja)

Ciamciaj opublikował(a) temat w Poradniki o SEO,

Lista 28 darmowych narzędzi SEO, każdy znajdzie coś dla siebie!-

-

- 24 odpowiedzi

Wybrany przez

Ciamciaj, -

-

.png.19f30b13db93f596837d9fef0f8312cc.png)

Rekomendowane odpowiedzi

Jeśli chcesz dodać odpowiedź, zaloguj się lub zarejestruj nowe konto

Jedynie zarejestrowani użytkownicy mogą komentować zawartość tej strony.

Zarejestruj nowe konto

Załóż nowe konto. To bardzo proste!

Zarejestruj sięZaloguj się

Posiadasz już konto? Zaloguj się poniżej.

Zaloguj się